面试狗 - interviewdog 项目笔记 前端初始化配置 Next.js 有两种开发模式(App Router / Page Router),注意,本项目用的是新的开发模式 App Router,建议看英文官方文档:https://nextjs.org/docs/getting-started/installation#automatic-installation

执行安装命令:

1 npx create-next-app@latest

历史 next-app 版本:https://www.npmjs.com/package/next?activeTab=versions

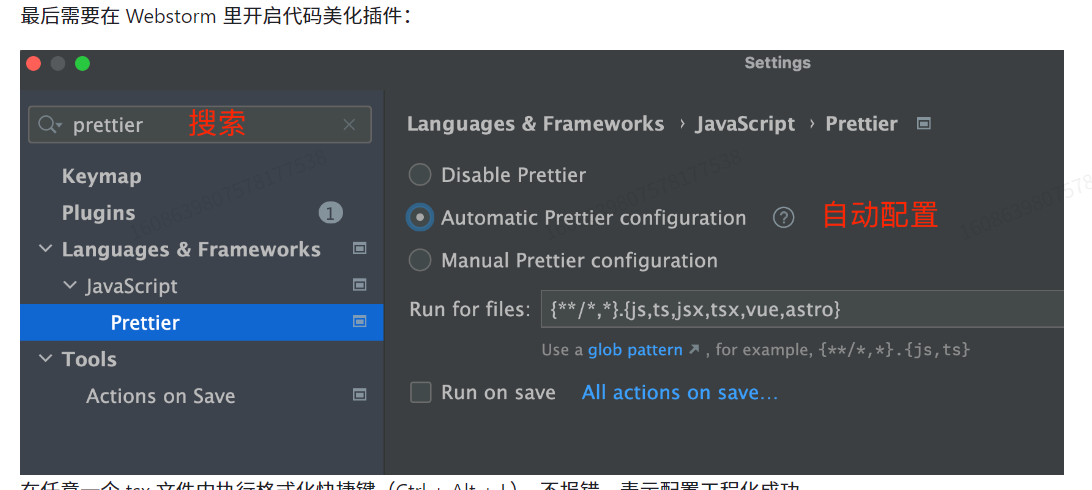

安装 prettier (代码自动格式化插件),安装命令

1 npm install --save-dev --save-exact prettier

修改 .eslintrc.json 文件可以改变校验规则,一般自己做项目不需要修改。

1 2 3 { "extends": ["next/core-web-vitals", "prettier"] }

如果报错 Error: Failed to load config “prettier” to extend from. Referenced from: D:\projects\interviewdog-frontend.eslintrc.json 则执行以下命令:

1 npm i eslint prettier-eslint eslint-config-prettier --save-dev

安装 antd 组件库

针对 App Router 模式的 Next.js,需要处理页面闪动情况

1 npm install @ant-design/nextjs-registry --save

修改页面全局布局文件 app/layout.tsx

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 import "./globals.css" ;import {AntdRegistry } from '@ant-design/nextjs-registry' ;export default function RootLayout ({ children, }: Readonly<{ children: React.ReactNode; }> ) { return ( <html lang ="en" > <body > <AntdRegistry > {children}</AntdRegistry > </body > </html > ); }

如果能在 page.tsx 文件中引入组件,则代表组件库安装成功

1 <Button type="primary">Primary Button</Button>

安装 Ant Design 高级组件:https://procomponents.ant.design/components/layout?tab=api#packages-layout-src-components-layout-tab-api-demo-base

1 npm i @ant-design/pro-components --save

注意,引入 Ant Design 后,不建议引入 Tailwind CSS 了,可能会有样式冲突

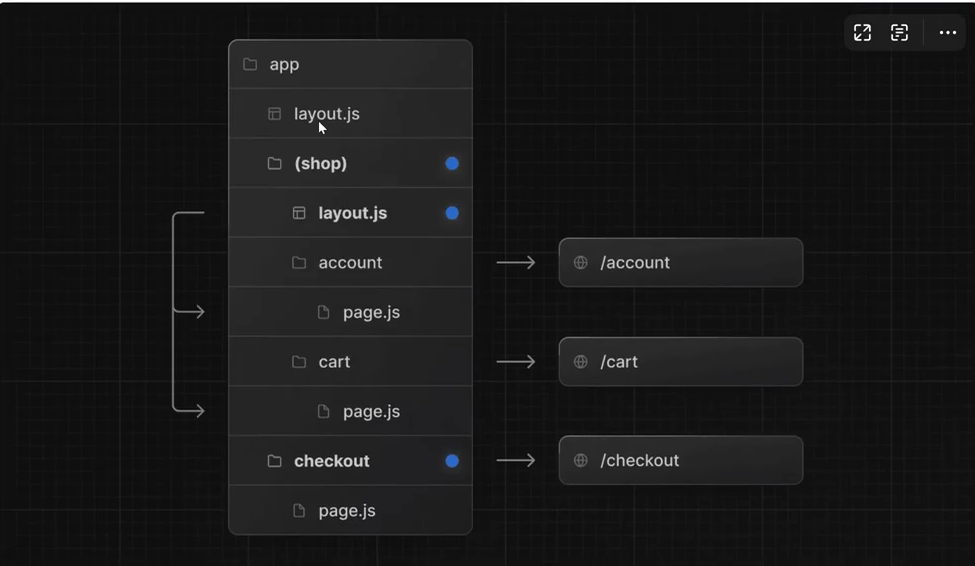

Next.js 开发规范 1、约定式路由 Next.js 使用 约定式路由,根据文件夹的结构和名称,自动将对应的 URL 地址映射到页面文件。

常见的几种路由规则如下: 1)基础规则:以 app 目录作为根路径,根据文件夹的名称和嵌套层级,自动映射为 URL 地址。注意,只有目录下直接包含 page 文件(js、jsx、ts、tsx都支持),才会被识别为路由。

2)路由组:可以通过(xxx)语法,创建一个路由组,不会被转化为路径,可用于对路由进行分组管理,比如同组路由使用同一套布局。

3)动态路由:可以通过[xxx]语法,让多个不同参数的 URL 复用同一个页面,比如app/question/[questionId]/page.tsx 中 questionld 就是动态路由参数,可以匹配 /question/1、/question/2 等URL地址,在页面中可以获取到 questionld 并加载不同的题目。

1 2 3 export default function Page ({ params }: { params: { questionId: string } } ) { return <div > 我的题目: {params.questionId}</div > }

以上只是 Next.js 的几种常用路由规则,还有其他的规则,详情可以见 Next.js 的官方文档:https://nextjs.org/docs/app/building-your-application/routing

2、静态资源 Next.js 约定 在 /public 目录下存放静态资源。在其中新建 assets 目录,可以在其中存放图片等静态资源文件,比如网站 logo

对应官方文档:https://nextjs.org/docs/app/building-your-application/optimizing/static-assets

接着可以使用 Next.js 的 Image 组件加载静态资源,比如:

1 <Image src={`/assets/logo.png`} alt={alt} width="64" height="64" />

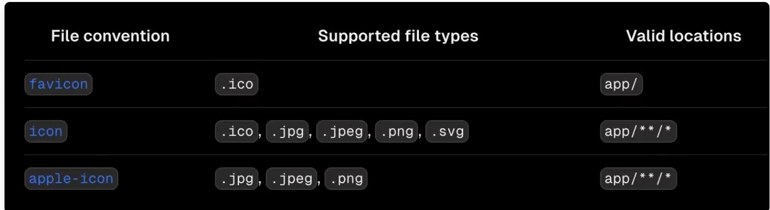

注意,某些特殊的、常用的元信息文件不是放在 public 目录下,而是应该根据特定规则放在 app 目录下!对应官方文档:https://nextjs.org/docs/app/api-reference/file-conventions/metadata比如将 favicon.ico 放到 app 的根目录下,可展示站点小图标:

3、文件组织形式 首先,项目中的每个页面和组件都是单独的文件夹。

基于 Nextjs 的约定式路由,我们每个页面目录内需要添加 page.tsx页面文件和 index.css 样式文件;每个组件目录内添加 index.tsx页面文件和index.css 样式文件。

对于项目中多页面公用的组件,放在src/components目录下;对于某个页面私有的组件,放在该页面的components 目录下

4、页面开发规范 Next.js 支持 React 的语法,可以用函数的方式声明页面和组件。每个页面的根元素必须有 id、每个组件根元素必须有 className,用于控制样式和快速定位。

1)**为了区分服务端和客户端渲染,每个页面(或组件)都必须在开头显示编写use client或use server**比如定义一个客户端渲染的页面,代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 "use client" ;import "./index.css" ;export default function HomePage ( return ( <main id ="homePage" > <div > 程序员鱼皮x编程导航的项目教程 </div > </main > ); }

2)定义组件时,需要使用 ts 声明组件属性的类型,比如:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 "use client" ;import { Viewer } from "@bytemd/react" ;import "./index.css" ;interface Props { value?: string ; } const MdViewer = (props: Props ) => { const { value = "" } = props; return ( <div className ="md-viewer" > <Viewer value ={value} plugins ={plugins} /> </div > ); }; export default MdViewer ;

5、其他注意事项 1)开发时要严格注意 TypeScript 的类型和编辑器的错误提示,并且定期打包构建。因为 Next.js 的构建要求非常严格,稍有不慎就会报错。构建报错的话,注意查看和处理构建中的报错信息。

2)在项目中慎用 window 等浏览器环境才支持的对象,服务端无法使用。注意保证客户端渲染页面和服务端渲染页面的一致性,否则会出现水合错误。

前端万能模板开发

Next.js 的页面名称要为 page.tsx,React 则为 index.tsx

全局通用布局 先创建 layouts 布局目录,创建一个基础布局,并将基础布局组件包裹 layout.tsx 文件的 children 属性

layout.tsx:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 import "./globals.css" ;import {AntdRegistry } from '@ant-design/nextjs-registry' ;import BasicLayout from "@/layouts/BasicLayout" ;import React from "react" ;export default function RootLayout ({ children, }: Readonly<{ children: React.ReactNode; }> ) { return ( <html lang ="en" > <body > <AntdRegistry > <BasicLayout > {children} </BasicLayout > </AntdRegistry > </body > </html > ); }

src/layouts/BasicLayout/index.tsx:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 "use client" ;import {GithubFilled , LogoutOutlined , PlusCircleFilled , SearchOutlined ,} from '@ant-design/icons' ;import {ProLayout ,} from '@ant-design/pro-components' ;import {Dropdown , Input ,} from 'antd' ;import React from 'react' ;import Image from "next/image" ;import {usePathname} from "next/navigation" ;import Link from "next/link" ;import GlobalFooter from "@/components/GlobalFooter" ;import {menus} from "../../../config/menu" ;const SearchInput = ( return ( <div key ="SearchOutlined" aria-hidden style ={{ display: 'flex ', alignItems: 'center ', marginInlineEnd: 24 , }} onMouseDown ={(e) => { e.stopPropagation(); e.preventDefault(); }} > <Input style ={{ borderRadius: 4 , marginInlineEnd: 12 , }} prefix ={ <SearchOutlined /> } placeholder="搜索题目" variant="borderless" /> </div > ); }; interface Props { children : React .ReactNode } export default function BasicLayout ({children}: Props ) { const pathname = usePathname (); return ( <div id ="basicLayout" style ={{ height: '100vh ', overflow: 'auto ', }} > <ProLayout title ="面试狗" logo ={ <Image src ="/assets/logo.png" height ={32} width ={32} alt ="面试狗" /> } layout="top" location={{ pathname, }} avatarProps={{ src: 'https://gw.alipayobjects.com/zos/antfincdn/efFD%24IOql2/weixintupian_20170331104822.jpg', size: 'small', title: 'C1own', render: (props, dom) => { return ( <Dropdown menu ={{ items: [ { key: 'logout ', icon: <LogoutOutlined /> , label: '退出登录', }, ], }} > {dom} </Dropdown > ); }, }} actionsRender={(props) => { if (props.isMobile) return []; return [ <SearchInput key ="searchInput" /> , <a href ="https://www.github.com/dnwwdwd" target ="_blank" key ="github" > <GithubFilled key ="GithubFilled" /> , </a > ]; }} headerTitleRender={(logo, title, _) => { const defaultDom = ( <a > {logo} {title} </a > ); if (typeof window === 'undefined') return defaultDom; if (document.body.clientWidth < 1400) { return defaultDom; } if (_.isMobile) return defaultDom; return ( <> {defaultDom} </> ); }} // 渲染底部栏 footerRender={(props) => { return <GlobalFooter /> ; }} onMenuHeaderClick={(e) => console.log(e)} menuDataRender={() => { return menus; }} menuItemRender={(item, dom) => ( <Link href ={item.path || '/'} target ={item.target} > {dom} </Link > )} > {children} </ProLayout > </div> ); };

其中 {children} 替换了原来的 PageContainer 组件,这样不同的页面就可以复用公共的布局,同时不同的页面能显示不同的内容

1.在 prolayout 组件中配置 logo 和 title 属性可以修改导航栏 logo 和标题,将当前页面的 pathname 传给 location 属性时,这个 procomponents 组件库会自动渲染菜单项

另外在菜单项 item 可以通过添加 hideInMenu: true 来控制菜单项是否显示

2.在服务端渲染中获取 pathname 可通过 next.js 的 usePathname 实现

3.通过 menuDataRender 定义有哪些菜单项

1 2 3 4 5 6 7 8 9 10 11 12 menuDataRender={() => { return [ { path : 'questions' , name : '题目' }, { path : 'banks' , name : '题库' }, ] }}

4.根据 menuItemRender 指定点击菜单项的动作

1 2 3 4 5 6 7 menuItemRender={(item, dom ) => ( <Link href ={item.path || '/'} target ={item.target} > {dom} </Link > )}

5.通过 footerRender 可以渲染底部栏,我们可以自己定义一个底部栏并引入它

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 footerRender ={(props ) => { return <GlobalFooter /> }} import React from 'react' ;import './index.css' ;export default function GlobalFooter ( const currentYear = new Date ().getFullYear (); return ( <div className ="global-footer" > <div > @ {currentYear} AI 刷题平台</div > <a href ="https://www.github.com/dnwwdwd" target ="_blank" > 作者:C1own </a > </div > ); };

6.注意使用客户端渲染时,请删除关于 windows、useState document 相关的代码!!!

安装请求库 1、安装 axios 库

2、全局定义请求

在这个文件中可以配置全局响应拦截器和超时时间,是否携带 cookie 等

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 import axios from "axios" ;const myAxios = axios.create ({ baseURL : "http://localhost:8101" , timeout : 10000 , withCredentials : true , }); myAxios.interceptors .request .use ( function (config ) { return config; }, function (error ) { return Promise .reject (error); }, ); myAxios.interceptors .response .use ( function (response ) { const { data } = response; if (data.code === 40100 ) { if ( !response.request .responseURL .includes ("user/get/login" ) && !window .location .pathname .includes ("/user/login" ) ) { window .location .href = `/user/login?redirect=${window .location.href} ` ; } } else if (data.code !== 0 ) { throw new Error (data.message ?? "服务器错误" ); } return data; }, function (error ) { return Promise .reject (error); }, ); export default myAxios;

3、自动生成请求代码

安装自动生成请求接口代码库:

1 npm i --save-dev @umijs/openapi

在 项目根目录 新建openapi.config.ts ,根据自己的需要定制生成的代码:

1 2 3 4 5 6 7 const { generateService } = require ("@umijs/openapi" );generateService ({ requestLibPath : "import request from '@/libs/request'" , schemaPath : "http://localhost:8101/api/v2/api-docs" , serversPath : "./src" , });

4、执行生成代码的命令

在 package.json 文件中添加如下脚本

1 "openapi" : "ts-node openapi.config.ts"

如果执行如上命令出现 ts-node 不是内部或外部命令则 执行这个命令 npm install --save-dev ts-node

全局状态管理 1、什么是全局状态管理?

是指多个页面需要共享或者跟踪变化的变量,可以放到全局来统一维护,而不是每个页面分别维护和获取。适合作为全局状态的数据:记登录用户信息(每个页面几乎都要用)

在 Vue 中,主流的状态管理库有 Vuex 和 Pinia;在 React 项目中,主流的状态管理库是 Redux,本项目也将使用它。

2、Redux 基本概念

React Redux 官方文档:https://react-redux.js.org/Redux 中有一些常用的核心概念,不用理解,简单了解一下即可。 1)Store:整个应用状态(state)的容器,负责存储应用的状态,并提供访问状态、派发(dispatch)动作以及注册监听器等功能。 2)Action:一个普通的 JavaScript 对象,描述了状态变化的意图。每个 action 必须包含一个 type 字段表示动作类型。 一般开发中,我们会用一个字符串常量(Action Types)来标识不同的动作类型。比如改变计数器需要的 increment或 decrement:

1 2 const INCREMENT = 'INCREMENT' ;const DECREMENT = 'DECREMENT' ;

还会用 Action Creators 动作创建器函数来生成 action 对象,比如:

1 2 3 4 5 6 7 const increment = ( type : INCREMENT , }); const decrement = ( type : DECREMENT , });

3)Dispatch:用于发送 action,触发状态更新

4)Reducer:俗称状态处理器,根据当前状态和传入的 action 返回新的状态的函数。比如:

1 2 3 4 5 6 7 8 9 10 11 12 const initialState = { count: 0 }; function counterReducer(state = initialState, action) { switch (action.type) { case INCREMENT: return { ...state, count: state.count + 1 }; case DECREMENT: return { ...state, count: state.count - 1 }; default: return state; } }

3、状态管理实战

React Redux 官方入门文档:https://react-redux,js.org/tutorials/quick-start

由于我们使用的是 TypeScript,还要参考 TypeScript 的快速启动文档:https://react-redux.js.org/tutorials/typescriptquick-start 。对于新手,上面两个文档最好按顺序阅读。

其实以前 Redux 的使用成本还是稍微有点高的,但官方提供了 Redux Toolkit,可以简化使用 Redux 的开发。 1)安装

1 npm install @reduxjs/toolkit react-redux

2)配置 store

Store 是整个应用状态(state)的容器,负责存储应用的状态,并提供访问状态、派发(dispatch)动作以及注册监听器等功能。 在项目的 src 目录下新建 stores目录,用于存放所有的状态。然后在 stores目录下新建 index.ts 文件,创建一个空的 Redux Store:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 import {configureStore} from "@reduxjs/toolkit" ;import loginUser from "@/stores/loginUser" ;const store = configureStore ({ reducer : { loginUser, }, }); export type RootState = ReturnType <typeof store.getState >export type AppDispatch = typeof store.dispatch export default store;

3)在项目中引入 Redux Store,修改 app/layout.tsx 项目全局入口文件即可:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 import store from '@/stores' import { Provider } from 'react-redux' export default function RootLayout ({ children, }: Readonly<{ children: React.ReactNode; }> ) { return ( <html lang ="en" > <body > <AntdRegistry > <Provider store ={store} > <BasicLayout > {children}</BasicLayout > </Provider > </AntdRegistry > </body > </html > ); }

4)定义 Slice

Slice 是 Redux Toolkit 中的概念,它将状态和相关的 reducer 逻辑组织在一起,便于模块化管理。每个 sice 通常代表应用中的一部分状态(如用户、产品、购物车等)。

在没有 Redux Toolkit 和 Slice 之前,传统的 Redux 开发需要定义 action types、action creators 和 reducer 函数,所有这些通常需要在不同的文件中编写,增加了代码的复杂性和维护成本。

在 stores 目录下新建 loginUser.ts ,创建一个 slice 用于存储当前登录用户的信息。代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 import { createSlice, PayloadAction } from "@reduxjs/toolkit"; import { RootState } from "@/stores/index"; // 默认用户 const DEFAULT_USER: API.LoginUserVO = { userName: "未登录", userProfile: "暂无简介", userAvatar: "/assets/notLoginUser.png", userRole: "guest", }; /** * 登录用户全局状态 */ export const loginUserSlice = createSlice({ name: "loginUser", initialState: DEFAULT_USER, reducers: { setLoginUser: (state, action: PayloadAction<API.LoginUserVO>) => { return { ...action.payload, }; }, }, }); // 修改状态 export const { setLoginUser } = loginUserSlice.actions; export default loginUserSlice.reducer;

注意:全局状态信息只能在客户端组件获取

5)在 Store 中引入新创建的 Slice,写在 reducer 里:

1 2 3 4 5 6 7 import loginUser from "./loginUser" ;const store = configureStore ({ reducer : { loginUser, }, });

6)获取状态 注意,状态是维护在客户端的,可以在任意 客户端渲染 页面(或组件)中使用状态,服务端渲染无法使用。 使用下列语法获取状态:

1 const loginUser = useSelector ((state: RootState ) => state.loginUser );

7)修改状态

修改状态也很方便,可以在 首次进入页面时,尝试获取登录用户信息。修改 app/layout.tsx 的全局初始化逻辑,编写远程获取登录用户数据的代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 const InitLayout : React .FC < Readonly <{ children : React .ReactNode ; }> > = ({ children } ) => { const dispatch = useDispatch<AppDispatch >(); const doInitLoginUser = useCallback (async () => { const res = await getLoginUserUsingGet (); if (res.data ) { dispatch (setLoginUser (res.data )); } else { setTimeout (() => { const testUser = { userName : "测试登录" , id : 1 }; dispatch (setLoginUser (testUser)); }, 3000 ); } }, []); useEffect (() => { doInitLoginUser (); }, []); return <> {children}</> };

其中,通过 dispatch 触发全局状态的更新:

1 2 3 4 const dispatch = useDispatch<AppDispatch >();dispatch (setLoginUser ({...}));

扩展

有些页面可以不用获取全局初始化状态,比如用户登录和用户注册页,可以根据 pathname 判断:

1 2 3 4 5 6 7 8 9 10 const pathname = usePathname ();if ( !pathname.startsWith ("/user/login" ) && !pathname.startsWith ("/user/register" ) ) { ... }

全局权限管理 需求:能够灵活配置每个页面所需要的用户权限,由全局权限管理系统自动校验和拦截,而不需要在每个页面中编写权限校验代码,提高开发效率。 还要能够根据权限控制导航菜单的显隐,只有具有权限的菜单,才对用户可见。

实现方案 1.在路由配置文件,定义某个路由的访问权限。由于 Next.js 项目是约定式路由,只有我们自定义的菜单配置文件,可以在菜单配置文件中定义权限。

2.每次访问页面时,根据用户要访问页面的路由权限信息,判断用户是否有对应的访问权限,并进行相应的拦截处理。这是一个全局逻辑,可以在项目根布局app/layout.tsx中添加。

3.导航栏展示菜单时,可以过滤掉登录用户没有权限的菜单项,从而实现根据权限控制导航菜单的显隐

开发实现 1)在 app 目录下新建 forbidden 无权限页面,内容随便写,比如:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 import { Result , Button } from "antd" ;import React from "react" ;const Forbidden = ( return ( <Result status ="403" title ="403" subTitle ="抱歉,您无权访问此页面。 " extra ={ <Button type ="primary" href ="/" > 返回主页 </Button > } /> ); }; export default Forbidden ;

2)在 src 下新建 access 目录,所有权限管理相关的代码都放在该目录下,模块化。只要不引入,就不会生效。先在目录中定义权限枚举文件 accessEnum.ts:

1 2 3 4 5 6 7 8 9 10 const ACCESS_ENUM = { NOT_LOGIN : "notLogin" , USER : "user" , ADMIN : "admin" , }; export default ACCESS_ENUM ;

有了枚举类后,可以将全局状态中的默认用户权限改为“未登录”:

1 2 3 4 5 6 const DEFAULT_USER : API .LoginUserVO = { userName : "未登录" , userProfile : "暂无简介" , userAvatar : "/assets/notLoginUser.png" , userRole : AccessEnum .NOT_LOGIN , };

3)在菜单配置文件 menu.tsx 中补充对于权限的配置。比如:

1 2 3 4 5 6 7 8 9 10 11 12 13 { path : "/admin" , name : "管理" , icon : <CrownOutlined /> access : ACCESS_ENUM .ADMIN , children : [ { path : "/admin/user" , name : "用户管理" , access : ACCESS_ENUM .ADMIN , }, ], },

4)编写通用的权限校验方法

为什么?因为菜单组件中要判断权限、权限拦截也要用到权限判断功能,所以抽离成公共模块。新建 checkAccess.ts 文件,代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 /** * 检查权限(检查当前登录用户是否具有某个权限) * */ import AccessEnum from "@/access/accessEnum"; import ACCESS_ENUM from "@/access/accessEnum"; const checkAccess = ( loginUser: API.LoginUserVO, needAccess = AccessEnum.NOT_LOGIN, ) => { // 获取当前登录用户拥有的权限(如果没有登录,就代表没有权限) const loginUserAccess = loginUser?.userRole ?? ACCESS_ENUM.NOT_LOGIN; // 如果当前不需要任何权限 if (needAccess === AccessEnum.NOT_LOGIN) { return true; } // 如果页面需要登录才可访问 if (needAccess === AccessEnum.USER) { // 如果用户未登录,表示无权限 if (loginUserAccess === ACCESS_ENUM.NOT_LOGIN) { return false; } } // 如果需要管理员权限才可访问 if (needAccess === AccessEnum.ADMIN) { // 必须要有管理员权限,如果没有,则表示无权限 return loginUserAccess === AccessEnum.ADMIN; } return true; }; export default checkAccess;

有了枚举类后,可以将全局状态中的默认用户权限改为“未登录”:

1 2 3 4 5 6 const DEFAULT_USER : API .LoginUserVO = { userName : "未登录" , userProfile : "暂无简介" , userAvatar : "/assets/notLoginUser.png" , userRole : AccessEnum .NOT_LOGIN , };

3)在菜单配置文件中 menu.tsx 中补充对于权限的配置。比如:

1 2 3 4 5 6 7 8 9 10 11 12 13 { path : "/admin" , name : "管理" , icon : <CrownOutlined /> access : ACCESS_ENUM .ADMIN , children : [ { path : "/admin/user" , name : "用户管理" , access : ACCESS_ENUM .ADMIN , }, ], },

4——编写通用的权限校验方法。

为什么?因为菜单组件中要判断权限、权限拦截也要用到权限判断功能,所以抽离成公共模块。

新建 checkAccess.ts 文件,代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 import ACCESS_ENUM from "@/access/accessEnum" ;const checkAccess = (loginUser: API.LoginUserVO, needAccess = ACCESS_ENUM.NOT_LOGIN ) => { const loginUserAccess = loginUser?.userRole ?? ACCESS_ENUM .NOT_LOGIN ; if (needAccess === ACCESS_ENUM .NOT_LOGIN ) { return true ; } if (needAccess === ACCESS_ENUM .USER ) { if (loginUserAccess === ACCESS_ENUM .NOT_LOGIN ) { return false ; } } if (needAccess === ACCESS_ENUM .ADMIN ) { if (loginUserAccess !== ACCESS_ENUM .ADMIN ) { return false ; } } return true ; }; export default checkAccess;

可以根据自己的需要,修改判断权限的逻辑。

5)新增权限校验布局 AccessLayout.tsx,逻辑如下: 1.获取到 pathname 和 loginUser 2.根据 pathname 获取到对应的菜单项配置,并获取到所需的权限 3.调用 checkAccess 函数检测是否具有权限。如果有,则正常返回内容;如果没有,返回到无权限页面。

可以先在 menus.tsx 中编写“根据 pathname 获取到菜单项配置” 的函数,使用递归实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 export const findAllMenuItemByPath = (path : string ): MenuDataItem | null => return findMenuItemByPath (menus, path); }; export const findMenuItemByPath = ( menus : MenuDataItem [], path : string , ): MenuDataItem | null => for (const menu of menus) { if (menu.path === path) { return menu; } if (menu.children ) { const matchedMenuItem = findMenuItemByPath (menu.children , path); if (matchedMenuItem) { return matchedMenuItem; } } } return null ; };

然后就可以编写权限校验布局 AccessLayout.tsx,代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 import { useSelector } from "react-redux" ;import { RootState } from "@/stores" ;import { usePathname } from "next/navigation" ;import checkAccess from "@/access/checkAccess" ;import Forbidden from "@/app/forbidden" ;import React from "react" ;import { findAllMenuItemByPath } from "../../config/menus" ;import AccessEnum from "@/access/accessEnum" ;const AccessLayout : React .FC < Readonly <{ children : React .ReactNode ; }> > = ({ children } ) => { const pathname = usePathname (); const loginUser = useSelector ((state: RootState ) => state.loginUser ); const menu = findAllMenuItemByPath (pathname) || {}; const needAccess = menu?.access ?? AccessEnum .NOT_LOGIN ; const canAccess = checkAccess (loginUser, needAccess); if (!canAccess) { return <Forbidden /> } return <> {children}</> }; export default AccessLayout ;

可以在 RootLayout 中引入,嵌入到 BasicLayout 中:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 export default function RootLayout ({ children, }: Readonly<{ children: React.ReactNode; }> ) { return ( <html lang ="zh" > <body > <AntdRegistry > <Provider store ={store} > <InitLayout > <BasicLayout > <AccessLayout > {children}</AccessLayout > </BasicLayout > </InitLayout > </Provider > </AntdRegistry > </body > </html > ); }

6)根据权限控制菜单显隐 新建 menuAccess.ts 文件,提供获取可访问菜单的函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 import checkAccess from "@/access/checkAccess" ;import { menus } from "../../config/menus" ;const getAccessibleMenus = (loginUser: API.LoginUserVO, menuItems = menus ) => { return menuItems.filter ((item ) => { if (!checkAccess (loginUser, item.access )) { return false ; } if (item.children ) { item.children = getAccessibleMenus (loginUser, item.children ); } return true ; }); }; export default getAccessibleMenus;

扩展

还有其他实现权限校验的方法,比如使用高阶组件(HOC)在客户端进行权限校验,这种方法会更灵活。

创建一个 HOC 组件:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 import { useRouter } from 'next/router' ;import { useEffect } from 'react' ;import { useSelector } from 'react-redux' ; export default function withAuth (Component ) { return function AuthenticatedComponent (props ) { const router = useRouter (); const isAuthenticated = useSelector ((state ) => state.auth .isAuthenticated ); useEffect (() => { if (!isAuthenticated) { router.push ('/login' ); } }, [isAuthenticated]); if (!isAuthenticated) { return null ; } return <Component {...props } /> }; }

使用这个 HOC 包裹需要进行权限校验的页面:

1 2 3 4 5 6 7 8 import withAuth from '@/components/withAuth' ;function ProtectedPage ( return <div > This is a protected page.</div > } export default withAuth (ProtectedPage );

通用组件 - Markdown 富文本编辑器 安装命令:

1 2 npm i @bytemd/react npm i @bytemd/plugin-highlight @bytemd/plugin-gfm

在 /src/components 目录中新建 MdEditor 组件,编写代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 import { Editor } from "@bytemd/react" ;import gfm from "@bytemd/plugin-gfm" ;import highlight from "@bytemd/plugin-highlight" ;import "bytemd/dist/index.css" ;import "highlight.js/styles/vs.css" ;import "./index.css" ;interface Props { value?: string ; onChange?: (v: string ) => void ; placeholder?: string ; } const plugins = [gfm (), highlight ()];const MdEditor = (props: Props ) => { const { value = "" , onChange, placeholder } = props; return ( <div className ="md-editor" > <Editor value ={value} placeholder ={placeholder} mode ="split" plugins ={plugins} onChange ={onChange} /> </div > ); }; export default MdEditor ;

比如隐藏编辑器中不需要的操作图标(像 GitHub 图标):

1 2 3 .bytemd-toolbar-icon .bytemd-tippy .bytemd-tippy-right :last-child { display : none; }

MdViewer 实例代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 import { Viewer } from "@bytemd/react" ;import gfm from "@bytemd/plugin-gfm" ;import highlight from "@bytemd/plugin-highlight" ;import "bytemd/dist/index.css" ;import "highlight.js/styles/vs.css" ;import "./index.css" ;interface Props { value?: string ; } const plugins = [gfm (), highlight ()];const MdViewer = (props: Props ) => { const { value = "" } = props; return ( <div className ="md-viewer" > <Viewer value ={value} plugins ={plugins} /> </div > ); }; export default MdViewer ;

bytemd 组件引入 github css 样式

1 npm install github-markdown-css --force

参考上方文档安装之后,在 MdViewer和 MdEditor 中引入样式文件:

1 import 'github-markdown-css/github-markdown-light.css' ;

前端页面开发 前端页面开发,跑通前后端核心业务流程,主要包括:

基础页面开发

核心页面开发

主页

题库列表页

题目搜索页

题库详情页

题目详情页

题目题库绑定(管理员)

1、用户登录页面 可以使用 Ant Design ProComponents 的 ProForm 表单组件,先安装

1 npm i @ant-design/pro-form --force

运用 ProComponents 的登录表单,在其基础上修改即可

2、用户注册页面 与登录页面类似,只不过表单提交逻辑和多了一个输入框

3、用户管理页面 安装表格组件依赖:

1 npm i @ant-design/pro-table --force

扩展 1)用户管理页面可以通过给删除增加二次确认,减少误操作概率。使用 Popconfirm 组件可轻松实现:https://ant-design.antgroup.com/components/popconfirm-cn

2)用户管理页面实现多列排序功能 前端 ProTable 已经默认支持了,通过 request 函数的 sort 参数可以获取到排序条件,需要让后端支持处理多列排序。

4、题目管理页面 表格列配置:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 const columns : ProColumns <API .Question >[] = [ { title : "id" , dataIndex : "id" , valueType : "text" , hideInForm : true , }, { title : "标题" , dataIndex : "title" , valueType : "text" , }, { title : "内容" , dataIndex : "content" , valueType : "text" , hideInSearch : true , width : 240 , }, { title : "答案" , dataIndex : "answer" , valueType : "text" , hideInSearch : true , width : 640 , }, { title : "标签" , dataIndex : "tags" , valueType : "select" , fieldProps : { mode : "tags" , } }, { title : "创建用户" , dataIndex : "userId" , valueType : "text" , hideInForm : true , }, { title : "创建时间" , sorter : true , dataIndex : "createTime" , valueType : "dateTime" , hideInSearch : true , hideInForm : true , }, { title : "编辑时间" , sorter : true , dataIndex : "editTime" , valueType : "dateTime" , hideInSearch : true , hideInForm : true , }, { title : "更新时间" , sorter : true , dataIndex : "updateTime" , valueType : "dateTime" , hideInSearch : true , hideInForm : true , }, { title : "操作" , dataIndex : "option" , valueType : "option" , render : (_, record ) => ( <Space size ="middle" > <Typography.Link onClick ={() => { setCurrentRow(record); setUpdateModalVisible(true); }} > 修改 </Typography.Link > <Typography.Link type ="danger" onClick ={() => handleDelete(record)}> 删除 </Typography.Link > </Space > ), }, ];

处理特殊逻辑

1)自定标签渲染,把字符串转为标签列表:

1 2 3 4 5 6 7 8 9 10 11 12 { title : "标签" , dataIndex : "tags" , valueType : "select" , fieldProps : { mode : "tags" , }, render : (_, record ) => { const tagList = JSON .parse (record.tags || "[]" ); return <TagList tagList ={tagList} /> }, },

tagList 是用于渲染标签列表的组件:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 import { Tag } from "antd" ;import "./index.css" ;interface Props { tagList?: string []; } const TagList = (props: Props ) => { const { tagList = [] } = props; return ( <div className ="tag-list" > {tagList.map((tag) => { return <Tag key ={tag} > {tag}</Tag > ; })} </div > ); }; export default TagList ;

2)需要修改题目内容和答案的输入框为我们封装的 MdEditor 编辑器,可参考 ProTable 官方文档的 自定义表单项渲染。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 { title : "内容" , dataIndex : "content" , valueType : "text" , hideInSearch : true , width : 240 , renderFormItem : ( _, { type , defaultRender, formItemProps, fieldProps, ...rest }, form, ) => return ( <MdEditor // 组件的配置 {...fieldProps } /> ); }, },

3)注意,更新数据时,需要将 tags 转换成数组后作为表单初始值,否则无法正常同步到表单。可以在 UpdateModal 中自己 定义初始值对象:

1 2 3 4 5 let initValues = { ...oldData };if (oldData.tags ) { initValues.tags = JSON .parse (oldData.tags ) || []; }

然后在 ProTable 组件中使用初始值对象:

1 2 3 4 5 6 7 <ProTable type ="form" columns={columns} form={{ initialValues : initValues, }} />

核心页面开发 主页开发 利用 Title 组件显示标题,注意引入的库为 import Title from "antd/es/typography/Title";

利用 组件是组件变为流式布局,自定义题目列表和题库列表组件,并根据后端返回的值填入到对应的组件中

注意,主页为服务端渲染,但是主页用到的题目列表组件和题库列表组件需要单独抽离出来,并且为客户端渲染

ProTable 组件 1、对于 ProComponents 的表格 ProTable 组件,可以通过 hideInSearch: true,hideInForm: true,来显示控制某些列是否要展示在搜素框和表单中。

2、另外 ProTable 渲染多个标签时可以自己实现 render 函数,并自己封装标签列表组件再将标签列表传入其中。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 { title : "标签" , dataIndex : "tags" , valueType : "select" , fieldProps : { mode : "tags" , }, render : (_, record ) => { const tags = JSON .parse (record.tags || "[]" ); return <TagList tags ={tags}/ > }, hideInSearch : true , hideInForm : true , },

3、ProTable 表格中的数据的数据是通过 request 函数请求远程获取的,在 return 中我们需要将 total 和 data 的值改为后端返回的值。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 request={async (params, sort, filter) => { const sortField = Object .keys (sort)?.[0 ]; const sortOrder = sort?.[sortField] ?? undefined ; const {data, code} = await listQuestionByPageUsingPost ({ ...params, sortField, sortOrder, ...filter, } as API .QuestionQueryRequest ); const newData = data?.records || []; const newTotal = data?.total || 0 ; return { success : code === 0 , data : newData, total : newTotal, }; }} columns={columns}

demo:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 "use client" ;import React , {useState} from 'react' ;import {ProColumns , ProTable } from "@ant-design/pro-table" ;import {listQuestionByPageUsingPost} from "@/api/questionController" ;import TagList from "@/components/TagList" ;import {TablePaginationConfig } from "antd" ;interface Props { defaultQuestionList?: API .QuestionVO [], defaultTotal?: number , } const QuestionTable : React .FC = (props: Props ) => { const {defaultQuestionList, defaultTotal} = props; const [questionList, setQuestionList] = useState<API .QuestionVO []>(defaultQuestionList || []); const [total, setTotal] = useState<number >(defaultTotal || 0 ); const columns : ProColumns <API .Question >[] = [ { title : '标题' , dataIndex : 'title' , valueType : 'text' , hideInSearch : true , hideInForm : true , }, { title : "标签" , dataIndex : "tags" , valueType : "select" , fieldProps : { mode : "tags" , }, render : (_, record ) => { const tags = JSON .parse (record.tags || "[]" ); return <TagList tags ={tags}/ > }, hideInSearch : true , hideInForm : true , }, { title : '创建人' , dataIndex : 'userId' , valueType : 'text' , hideInSearch : true , hideInForm : true , }, ]; return ( <div className ="questionTable" > <ProTable<API.QuestionVO > rowKey="key" size="large" search={{ labelWidth: "auto", }} pagination={{ pageSize: 12, showTotal: (total) => `总共${total}条`, showSizeChanger: false, total, } as TablePaginationConfig} request={async (params, sort, filter) => { const sortField = Object.keys(sort)?.[0]; const sortOrder = sort?.[sortField] ?? undefined; const {data, code} = await listQuestionByPageUsingPost({ ...params, sortField, sortOrder, ...filter, } as API.QuestionQueryRequest); // 更新结果 const newData = data?.records || []; const newTotal = data?.total || 0; setQuestionList(newData); setTotal(newTotal); return { success: code === 0, data: newData, total: newTotal, }; }} columns={columns} /> </div > ); }; export default QuestionTable;

4、ProTable 组件的 form 参数可以通过 initialValus 参数配置初始值

1 2 3 form={{ initialValues : defaultSearchParams }}

ProTable 组件还支持多选表格项,可以通过配置 rowSelection、tableAlertRender、tableAlertOptionRender 等属性实现

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 <ProTable<TableListItem> columns={columns} rowSelection={{ // 自定义选择项参考: https://ant.design/components/table-cn/#components-table-demo-row-selection-custom // 注释该行则默认不显示下拉选项 selections: [Table.SELECTION_ALL, Table.SELECTION_INVERT], defaultSelectedRowKeys: [1], }} tableAlertRender={({ selectedRowKeys, selectedRows, onCleanSelected, }) => { console.log(selectedRowKeys, selectedRows); return ( <Space size={24}> <span> 已选 {selectedRowKeys.length} 项 <a style={{ marginInlineStart: 8 }} onClick={onCleanSelected}> 取消选择 </a> </span> <span>{`容器数量: ${selectedRows.reduce( (pre, item) => pre + item.containers, 0, )} 个`}</span> <span>{`调用量: ${selectedRows.reduce( (pre, item) => pre + item.callNumber, 0, )} 次`}</span> </Space> ); }} tableAlertOptionRender={() => { return ( <Space size={16}> <a>批量删除</a> <a>导出数据</a> </Space> ); }} dataSource={tableListDataSource} scroll={{ x: 1300 }} options={false} search={false} pagination={{ pageSize: 5, }} rowKey="key" headerTitle="批量操作" toolBarRender={() => [<Button key="show">查看日志</Button>]} />

next.js 中在组件形参中加上 searchParams 默认就能获取搜索参数的值

题库详情页 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 "use server" ;import "./index.css" ;import {Avatar , Button , Card , message} from "antd" ;import {getQuestionBankVoByIdUsingGet} from "@/api/questionBankController" ;import Meta from "antd/es/card/Meta" ;import Paragraph from "antd/es/typography/Paragraph" ;import QuestionList from "@/components/QuestionList" ;import Title from "antd/es/typography/Title" ;export default async function BankPage ({ params } ) { const { questionBankId } = params; let bank = undefined ; try { const res = await getQuestionBankVoByIdUsingGet ({ id : questionBankId, needQueryQuestionList : true , pageSize : 200 , }); bank = res?.data ; } catch (e) { message.error ("获取题目失败," + e.message ); } if (!bank) { return <div > 获取题库详情失败,请刷新重试</div > } let firstQuestionId; if (bank.questionPage ?.records && bank.questionPage .records .length > 0 ) { firstQuestionId = bank.questionPage .records [0 ]; } return ( <div id ="bankPage" className ="max-width-content" > <Title level ={2} > {bank.name}</Title > <Card > <Meta avatar ={ <Avatar src ={bank.picture} size ={72}/ > } title={ <Title level ={3} style ={{marginBottom: 0 }}> {bank.title} </Title > } description={ <> <Paragraph type ="secondary" ellipsis ={{rows: 1 }} style ={{marginBottom: 0 }}> {bank.description} </Paragraph > <Button type ="primary" shape ="round" href ={ `/bank /${questionBankId }/question /${firstQuestionId }`} target ="_blank" disabled ={!firstQuestionId} > 开始刷题</Button > </> } /> </Card > <div style ={{marginBottom: 16 }}> </div > <QuestionList questionList ={bank.questionPage.records ?? []} cardTitle ={ `題目列表 (${ bank.questionPage ?.total ?? 0 })`} questionBankId ={questionBankId}/ > </div> ); }

题目详情页 需求:有两种不同的题目详情页

1.从题库进入的题目详情页:左侧需要展示题库内的题目列表。路由:/bank/[bankld]/question/[questionld

2.从其他位置(比如主页、搜索页)进入的题目详情页,不需要展示题库列表。路由:/question/[questionld] 这两个页面极为相似,可以直接开发额外展示题目列表的题目详情页,另一个页面复制并删减即可

为什么题目详情页的标题要是一级的 => 为了被搜索引擎爬虫收录

对于 Ant Design 组件库,凡是某个组件定义了 React.Node 都是可以传组件的

Menu 组件如何实现选中菜单高亮?

通过往 selectedKeys 属性传 数组实现对应的菜单项高亮

1 <Menu items={questionMenuItemList} selectedKeys={[question.id ]}/>

1、可以根据 useForm 函数获取 form 表的参数

2、根据 setFieldValue 函数设置表单项的值

1 2 const [form] = Form .useForm ();form.setFieldValue ("questionBankIdList" , questionBankIdList);

3、Select 组件支持传入 options 属性指定下拉框所选项

1 2 3 4 5 6 options={questionBankList.map ((questionBank ) => { return { label : questionBank.title , value : questionBank.id , }; })}

4、Select 组件还支持传入 onSelect 函数和 onDeselect 函数,使得选中、取消选中值时编写相应逻辑,比如给后端发请求

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 onSelect={async (value) => { const hide = message.loading('正在更新'); try { await addQuestionBankQuestionUsingPost({ questionId, questionBankId: value, }); hide(); message.success('绑定题库成功'); return true; } catch (error: any) { hide(); message.error('绑定题库失败,' + error.message); return false; } }}

扩展思路:

1、预渲染 通过 官方文档 了解 Next.js 的 prefetch 预渲染机制,进行性能优化。

比如页面内的链接过多时,预渲染次数会很多,可以将 prefetch 关闭来减少预渲染:

2、Metadata Next.js 支持通过 Metadata 设置页面的 TDK(标题、描述、关键词)等网页元信息。可参考官方文档:https://nextjs.org/docs/app/building-your-application/optimizing/metadata

3、请求缓存 Next.is 扩展了原生的 fetch,支持请求数据的服务端缓存,是提升性能、减少资源占用的好方法。可以参考官方获取数据的文档:https://nextjs.org/docs/app/building-your-application/data-fetching但是,我们项目中使用的 Axios 库是不支持缓存的!有其他的方式来实现缓存:1)可以在 getStaticProps 或 getServerSideProps 中使用 Axios 来获取数据,然后通过 Next.js 的 revalidate选项来控制页面或数据的重新生成时间。

4、并发请求

如果同一个页面要多次请求后端,串行可能会很慢,导致页面迟迟不返回。因此可以并发调用多个接口来获取数据,使用 promise.all 语法即可。

用户刷题记录日历 需求分析 为了鼓励用户多在网站上刷题,并且能自主复盘学习情况,增加成就感,需要支持用户刷题记录日历功能。

每个用户有自己的签到记录,具体拆解为 2 个子需求:

用户每日首次浏览题目,算作是签到,会记 统中。

用户可以在前端以图表的形式查看自己在 某个年份 的刷题签到记录(每天是否有签到)

方案设计 后端方案 — 基于数据库

1 2 3 4 5 6 7 CREATE TABLE user_sign_in ( id BIGINT AUTO_INCREMENT PRIMARY KEY, userId BIGINT NOT NULL , signDate DATE NOT NULL , createdTime TIMESTAMP DEFAULT CURRENT_TIMESTAMP , UNIQUE KEY uq_user_date (userId, signDate) );

通过唯一索引,可以确保同一用户在同一天内只能签到一次。通过下面的 SQL 即可查询用户的签到记录:

1 2 SELECT signDate FROM user_sign_in WHERE userId = ? AND signDate BETWEEN ?AND ?;

优点:原理简单,容易实现,适用于用户量较小的系统

缺点:随着用户量和数据量增大,对数据库的压力增大,直接查询数据库性能较差。除了单接口的响应会增加,可能整个系统都会被其拖垮。

后端方法—基于 Redis Set

可以利用内存缓存加速读写,常用的本地缓存是 Caffeine,分布式缓存是 Redis。由于每个用户会有多个签到记录,很适合使用 Redis 的 Set 类型存储,每个用户对应一个键,Set 内的每个元素为签到的具体日期。

Redis Key的设计为:user:signins:{userId}

其中:

user 是业务领域前缀

signins 是具体操作或功能

{userld}表示每个用户,是动态值

如果 Redis 被多个项目公用,还可以在开头增加项目前缀区分,比如 mianshiya:user:signins:{userId}。

该方案的优点:Set 数据结构天然支持去重,适合存储和检索打卡记录。

缺点:上述设计显然存储了很多重复的字符串,针对海量数据场景,需要考虑内存的占用量。

比如下列数据:

1 2 key = user:signins:123 value = ["2024-09-01", "2024-09-02", "2024-10-01", "2024-10-02"]

其中年份被重复存储。

为了减少内存占用,还可以在 key 中增加更多日期层级,比如 user:signins:{year}:{userId},实例命令如下:

1 2 SADD user:signins:2024:123 "09-01" SADD user:signins:2024:123 "10-01"

这样一来,不仅节约了内存,也便于管理,可以轻松查询某个用户在某个年份的签到情况。

💡 存储 100 万个用户 的 365 天 签到记录,使用 Redis 集合类型来存储每个用户的签到信息,每个用户需要大约 1880 字节1608639807578177538_0.9860546375639874 的空间,总共需要大约 1.88GB 的内存空间,相比数据库节约了 10 倍左右。

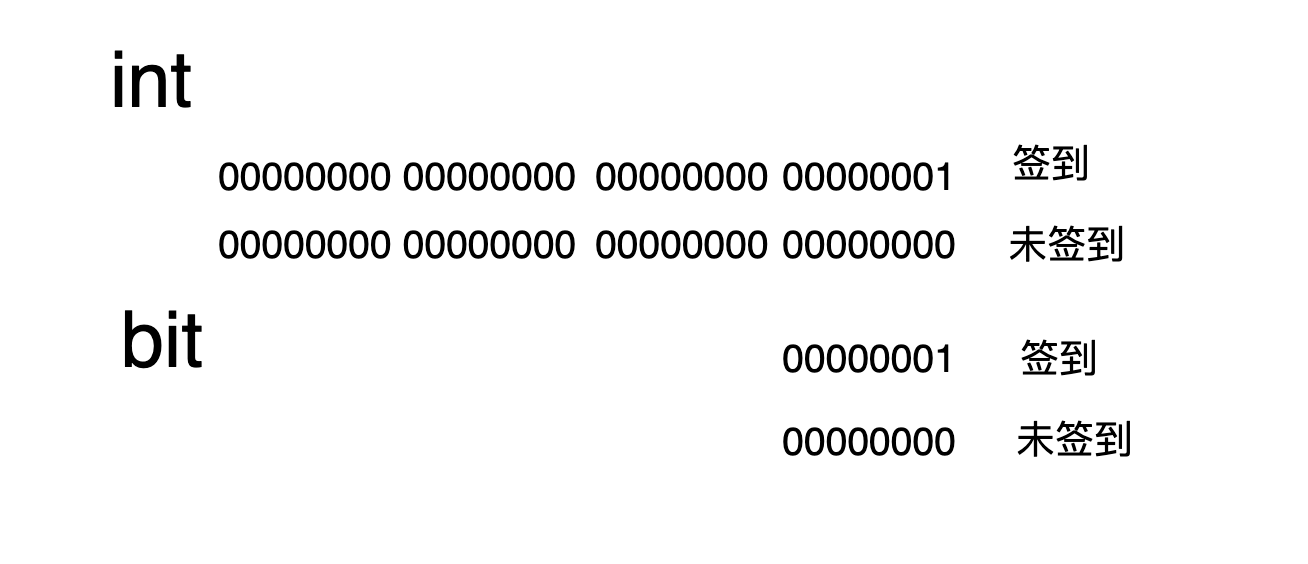

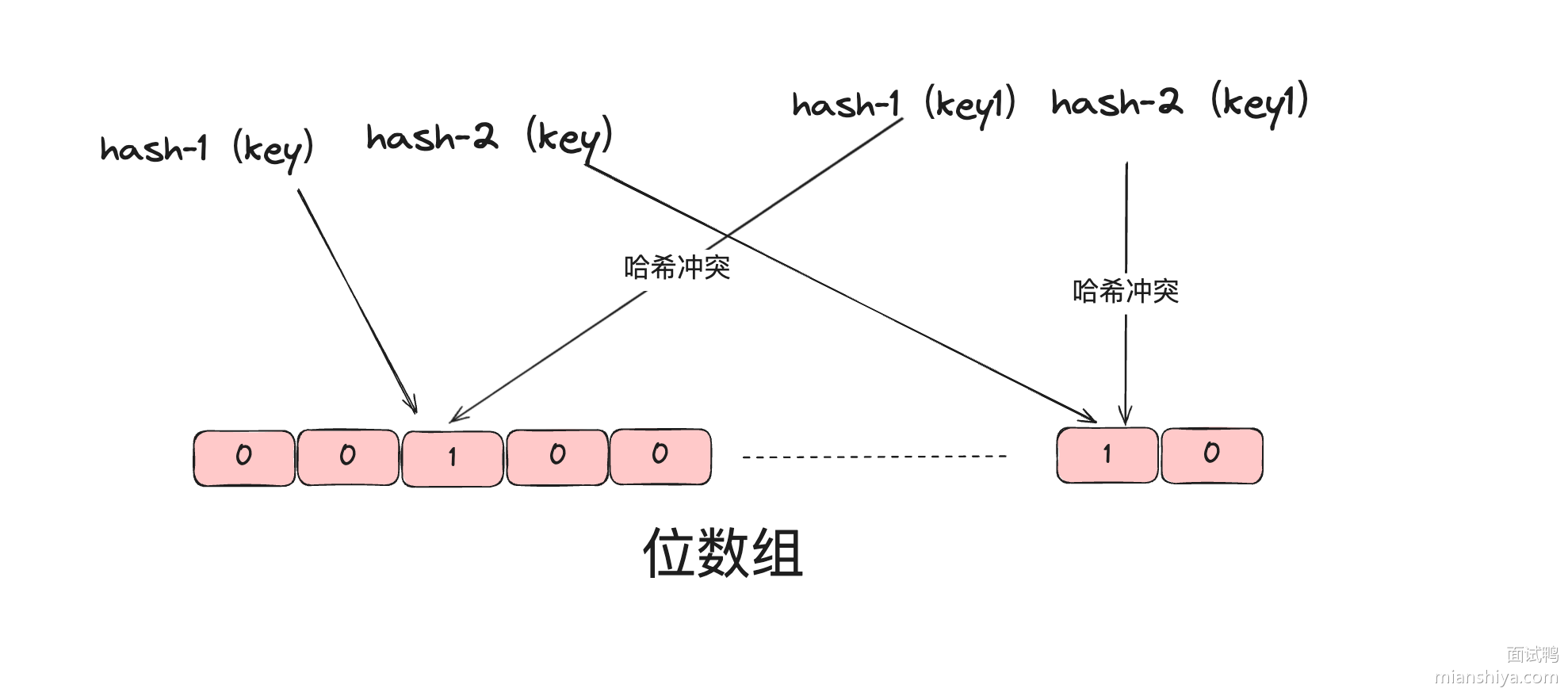

后端方案—BitMap位图

位图是一个用位表示数据的紧凑数据结构,每个位可以存储两个值:0 或 1,常用于表示某种状态。在签到系统中,可以用 1 表示已签到,0 表示未签到。以用户的 id 和年份作为 key,1 和 0 表示用户在一年中是否签到,bitmap 本质是有 Zset 实现的,所以我们可以这么是设计,假如用户在第一天签到了,那么 zset 索引为 0 的位置改为 1,假如在第 30 天签到了,那么 zset 索引为 29 的位置改为 1,其余就为 0。最后我们遍历 Zset 集合,根据值为 1 的索引与本年的第一天进行计算,从而算出签到的日期。

现代计算机体系结构通常以字节(8位)作为最小寻址单位,那么上述的 bit 是如何存储的呢?

答案就是 打包 。

对每一位操作时,要使用位运算进行访问,所以上述的图实际应该改成:

💡 对于刷题签到记录场景,一个用户存储一年的数据仅需占用 46 字节,因为 46 * 8 = 368,能覆盖 365 天的记录。那一百万用户也才占用 43.8 MB,相比于 Redis Set 结构节约了 40 多倍存储空间!

1000w 个用户也才占用 438 MB!恭喜你,设计出了一个低成本支持千万用户的系统!

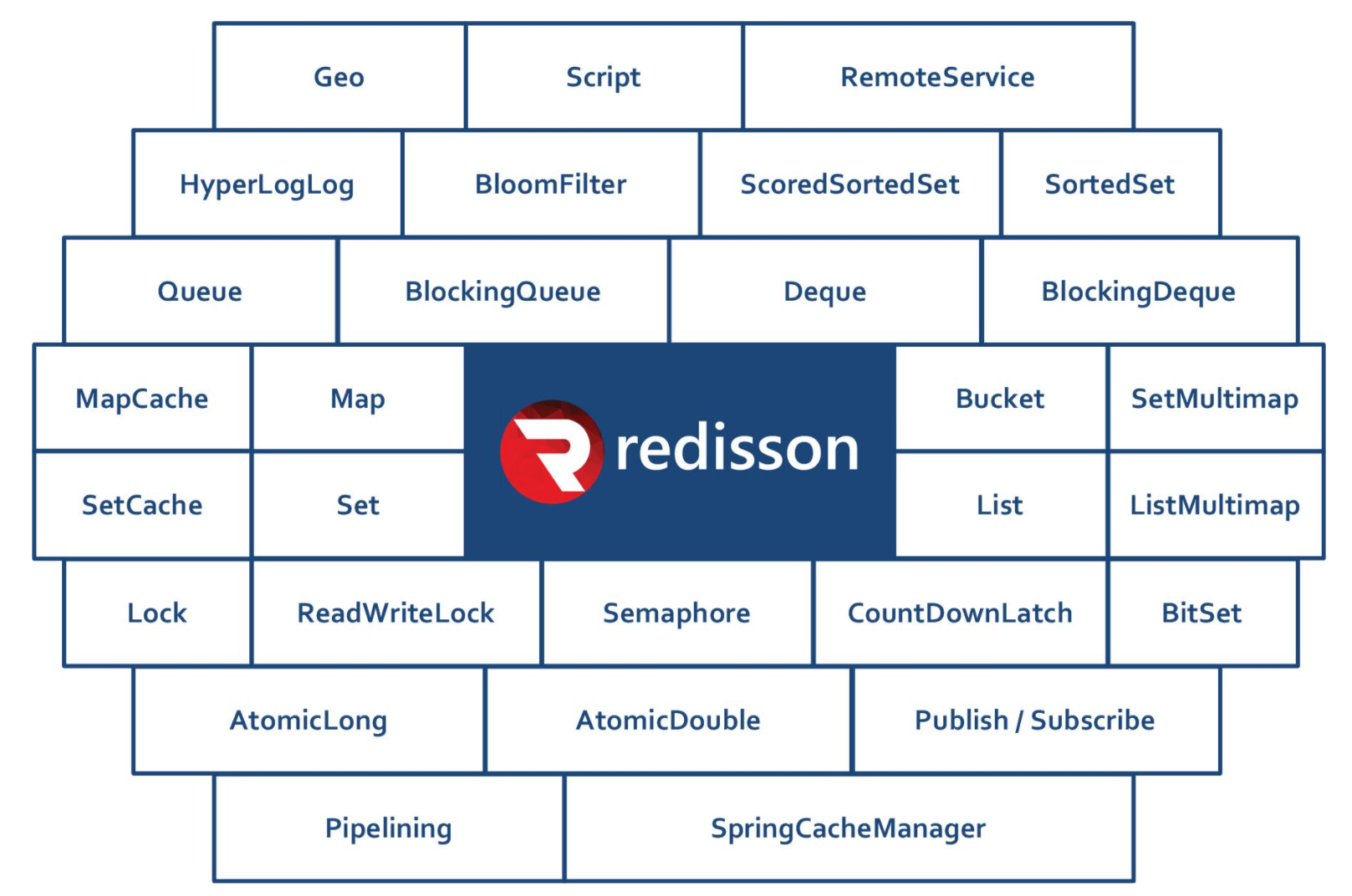

当然,我们没必要自己通过 int 等类型实现 Bitmap,JDK 自带了 BitSet 类、Redis 也支持 Bitmap 高级数据结构。考虑到项目的分布式、可扩展性,采用 Redis 的 Bitmap 实现。

综上所述,Redis Key 的设计为:user:signins:{年份}:{userId}

在 Java 程序中,还可以使用 Redisson 库提供的现成的 RBitSet,开发成本也很低。

这种方案的优点:内存占用极小,适合大规模用户和日期的场景。

缺点:需要熟悉位图操作,不够直观。

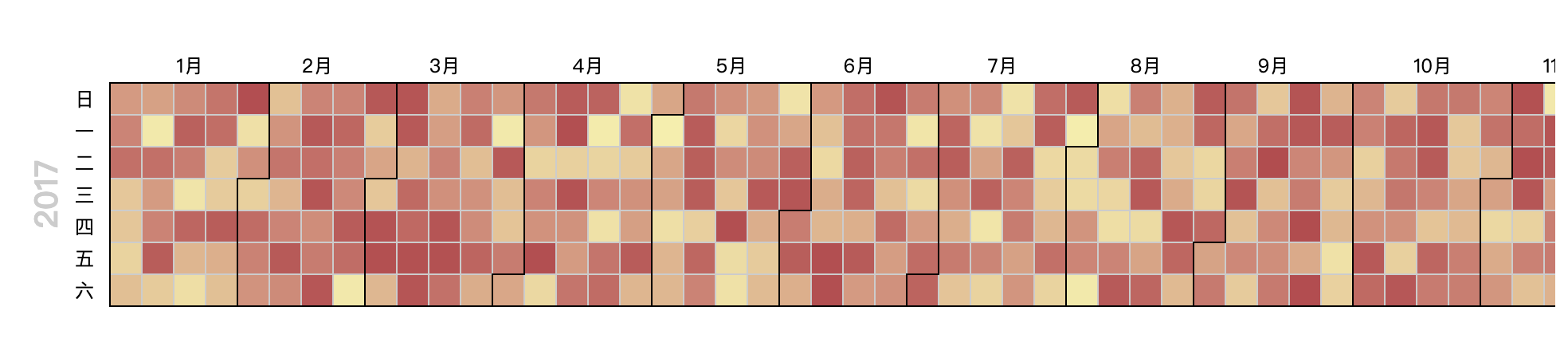

前端方案 要明确前端展示签到记录日历所需的数据类型,后端才好设计接口的返回值,因此方案设计阶段要考虑全面。 复杂的展示组件肯定不用自己开发,只要是图表(可视化),就可以优先考虑使用 Apache Echarts 前端可视化库,有3种可行的组件:

1.基础日历图:https://echarts.apache.org/examples/zh/editor.html?c=calendar-simple

2.日历热力图:https://echarts.apache.org/examples/zh/editor.htm!?c=calendar-heatmap,跟上一个图的区别就是鼠标放上去可以展示具体的热力值,热力值越高,图块的颜色越深。

3.日历图:https://echarts.apache.org/examples/zh/editor.html?c=calendar-charts

本项目选择基础日历图即可,不涉及热力数值的区分(只有0和1签到/未签到的区别):

如下是官方 Demo 的数据格式:

1 2 3 4 5 6 for (let time = date; time <= end; time += dayTime) { data.push ([ echarts.time .format (time, '{yyyy}-{MM}-{dd}' , false ), Math .floor (Math .random () * 10000 ) ]); }

很明显得到的数据是一个二位数组,每个元素表示对应的日期和热力值,很明显我们后端就要返回如上的结构的数据

1 2 3 4 5 [ ['2017-01-01' , 3456 ], ['2017-01-02' , 8975 ], ... ]

但回归我们的项目,用 Bitmap 每天最多只有一次记录,相当于只有 0 和 1。因此可以调整 Apache ECharts 图表的配置来调整热力值的范围,从而控制颜色深浅。还支持调整颜色:

1 2 3 4 5 6 7 8 visualMap : { show : false , min : 0 , max : 1 , inRange : { color : ['#efefef' , 'lightgreen' ] }, },

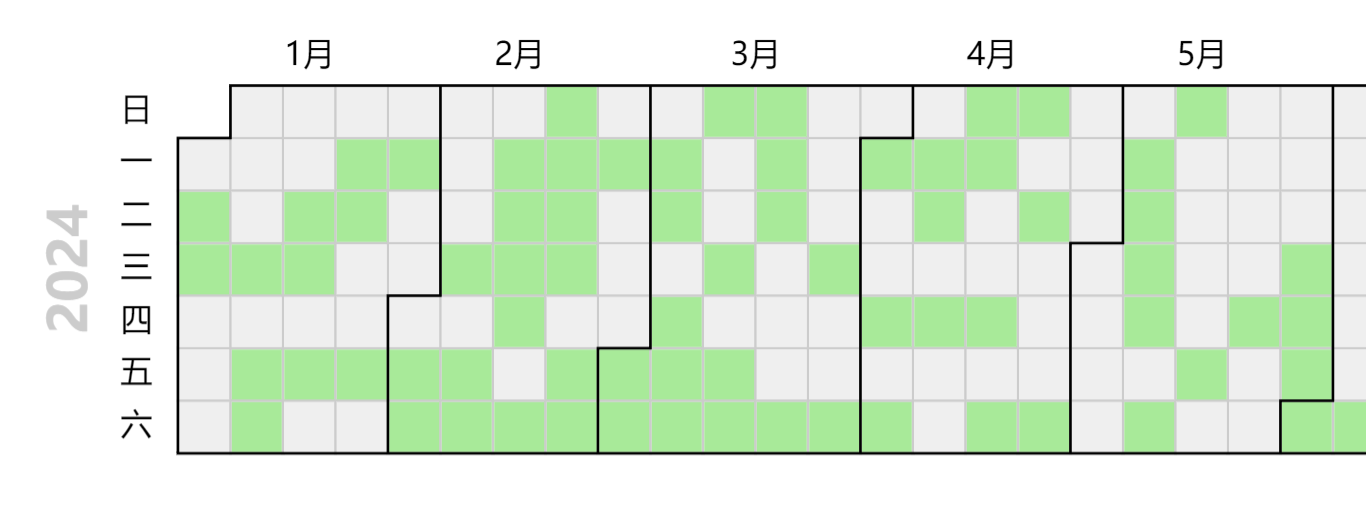

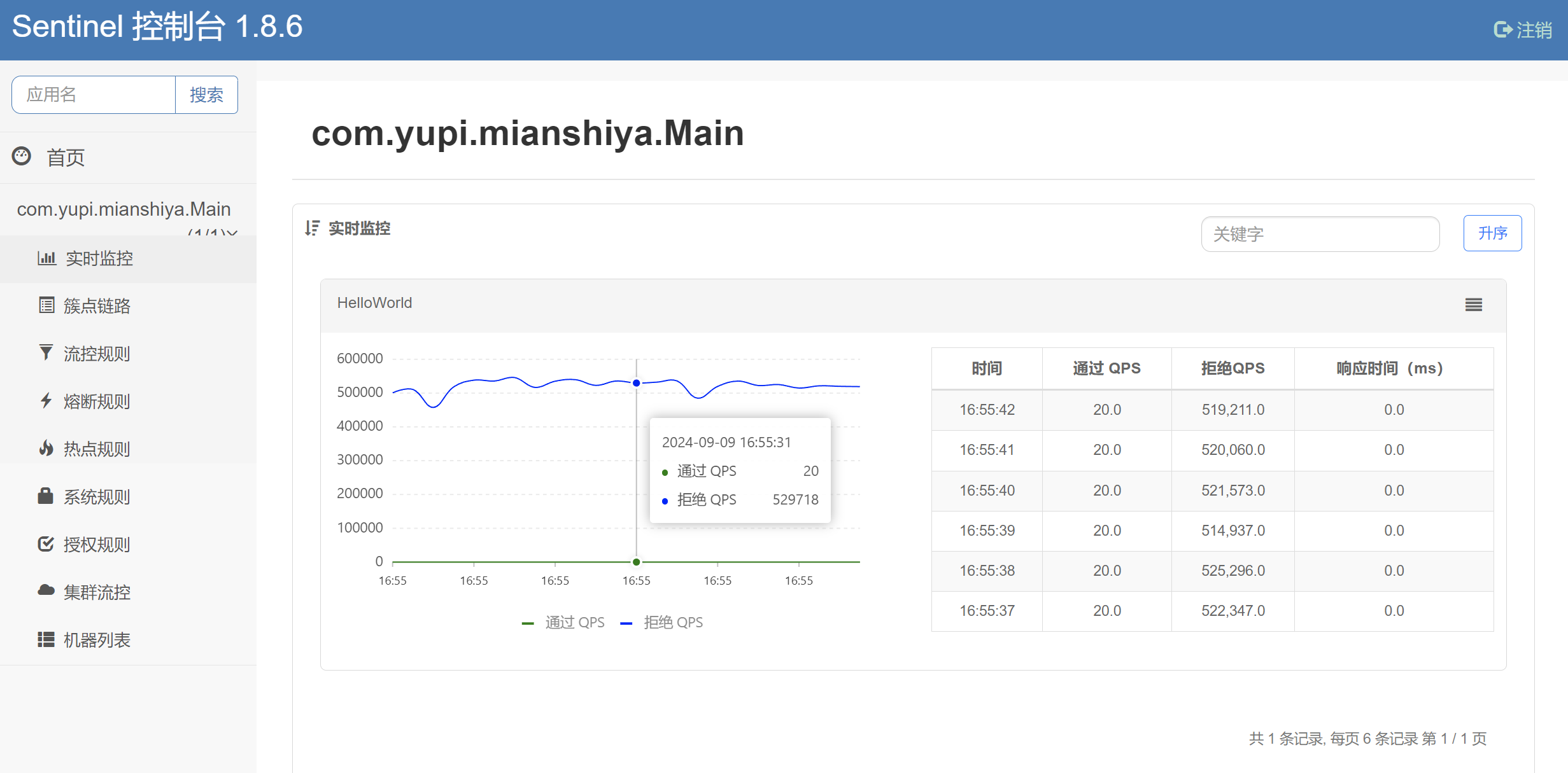

效果如图:

后端开发 因此我们要开发两个接口

用户添加签到记录接口

查询刷题签到记录接口

1、引入Redisson

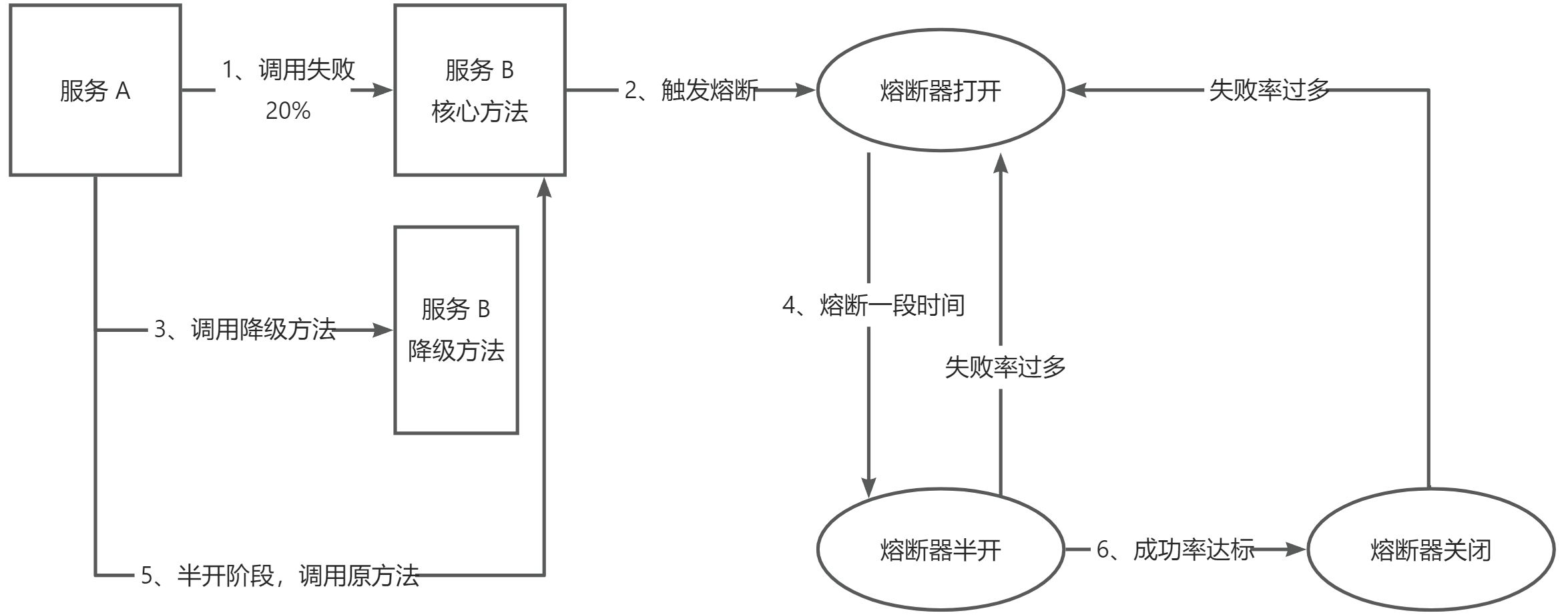

Redisson 是一个基于 Redis 的开源分布式 Java 数据库客户端,提供了类似 Java 标准库的数据结构(如 Map、Set、List、BitSet 等)在分布式环境下的实现。它不仅支持基本的 Redis 操作,还提供了高级功能,如分布式锁、同步器、限流器、缓存等,简化了在分布式系统中使用 Redis 进行数据共享和并发控制的复杂性。

1)引入 Redisson 依赖

1 2 3 4 5 <dependency > <groupId > org.redisson</groupId > <artifactId > redisson</artifactId > <version > 3.17.5</version > </dependency >

2)编写 Redisson 配置类

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 @Configuration @ConfigurationProperties(prefix = "spring.redis") @Data public class RedissonConfig { private String host; private String port; private String password; @Bean public RedissonClient redissonClient () { Config config = new Config (); String redisAddress = String.format("redis://%s:%s" , host, port); config.useSingleServer().setAddress(redisAddress).setDatabase(7 ).setPassword(password); RedissonClient redisson = Redisson.create(config); return redisson; } }

2、开发刷题签到记录接口

1 2 3 4 5 6 7 8 9 10 public boolean addUserSignIn (HttpServletRequest request) { User loginUser = this .getLoginUser(request); Long userId = loginUser.getId(); RBitSet bitSet = redisson.getBitSet(RedisConstant.getUserSignInRedisKey(userId)); int offset = LocalDateTime.now().getDayOfYear(); if (!bitSet.get(offset)) { return bitSet.set(offset); } return true ; }

3、开发签到记录查询接口

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 public Map<LocalDate, Boolean> getSignInRecord (long userId, Integer year) { if (year == null ) { year = DateUtils.getNowYear(); } String key = RedisConstant.getUserSignInRedisKey(year, userId); RBitSet signInBitSet = redisson.getBitSet(key); Map<LocalDate, Boolean> result = new LinkedHashMap <>(); int totalDays = Year.of(year).length(); for (int dayOfYear = 1 ; dayOfYear <= totalDays; dayOfYear++) { LocalDate currentDate = LocalDate.ofYearDay(year, dayOfYear); boolean hasRecord = signInBitSet.get(dayOfYear); result.put(currentDate, hasRecord); } return result; }

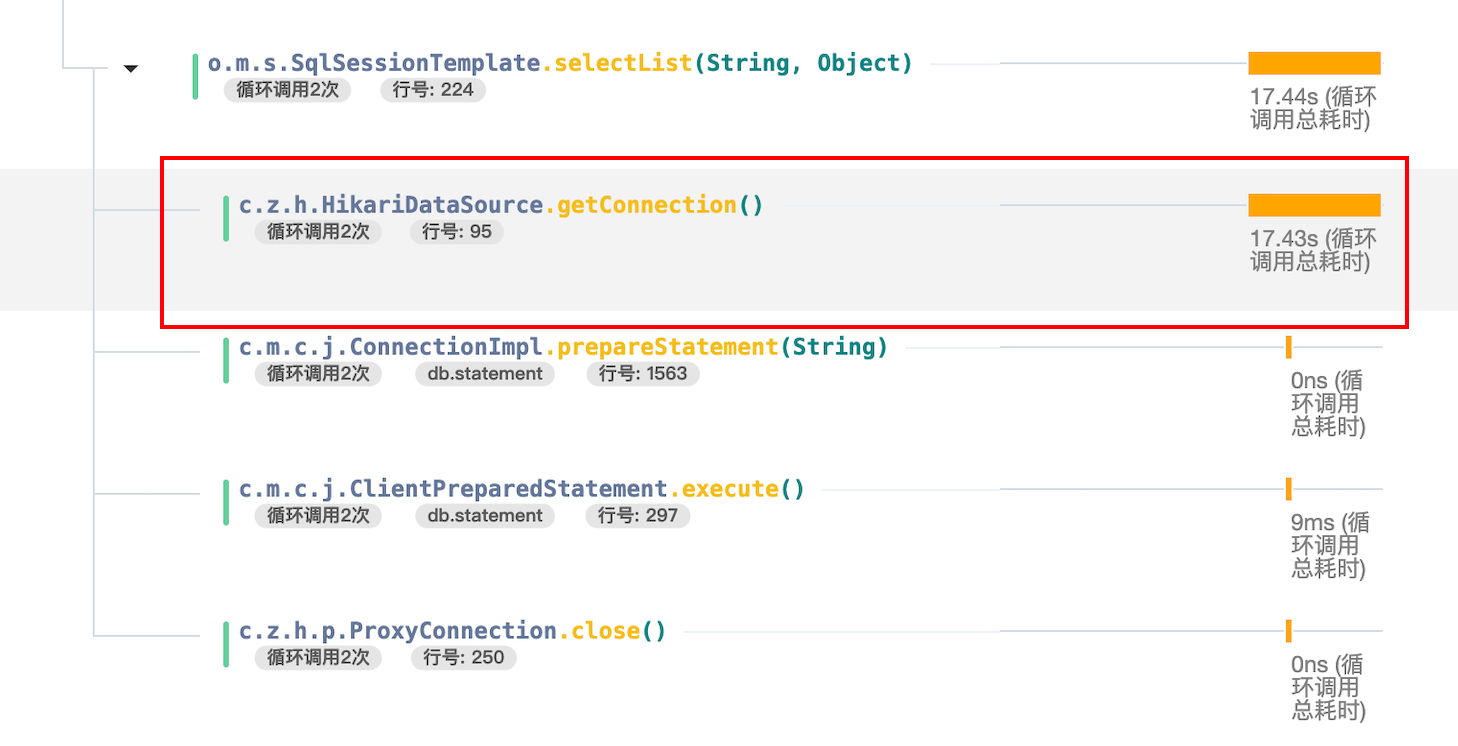

性能优化

由于每次查询用户的签到记录,都要访问 Redis 去查看是否有签到记录,每一个循环就要请求一次 Redis,这样就导致性能十分低下,因此我们可以通过本地缓存来降低对 Redis 的压力。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 public Map<LocalDate, Boolean> getSignInRecord (long userId, Integer year) { if (year == null ) { year = DateUtils.getNowYear(); } String key = RedisConstant.getUserSignInRedisKey(year, userId); RBitSet signInBitSet = redisson.getBitSet(key); BitSet bitSet = signInBitSet.asBitSet(); Map<LocalDate, Boolean> result = new LinkedHashMap <>(); int totalDays = Year.of(year).length(); for (int dayOfYear = 1 ; dayOfYear <= totalDays; dayOfYear++) { LocalDate currentDate = LocalDate.ofYearDay(year, dayOfYear); boolean hasRecord = bitSet.get(dayOfYear); result.put(currentDate, hasRecord); } return result; }

2、刷题记录返回优化

从返回结果看出传输的数据较多、计算时间较长、带宽占用较大,效率低

实际上我们继续将有刷题记录的日期返回给前端就好了,随后再由前段渲染刷过题的日期,其余就是没刷过题的

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 public List<Integer> getUserSignInRecord (long userId, Integer year) { if (year == null ) { LocalDate date = LocalDate.now(); year = date.getYear(); } String key = RedisConstant.getUserSignInRedisKey(year, userId); RBitSet signInBitSet = redissonClient.getBitSet(key); BitSet bitSet = signInBitSet.asBitSet(); List<Integer> dayList = new ArrayList <>(); int totalDays = Year.of(year).length(); for (int dayOfYear = 1 ; dayOfYear <= totalDays; dayOfYear++) { boolean hasRecord = bitSet.get(dayOfYear); if (hasRecord) { dayList.add(dayOfYear); } } return dayList; }

3、计算优化

上述代码中,我们使用循环来遍历所有年份,而循环是需要消耗CPU 计算资源的。在 Java 中的 Bitset 类中,可以使用 nextsetBit(int fromIndex)和 nextclearBit(int fromIndex)方法来获取从指定索引开始的下一个 已设置(即为 1) 或 未设置(即为 0) 的位。主要是 2 个方法: nextsetBit(int fromIndex):从 fromIndex 开始(包括 fromIndex 本身)寻找下一个被设置为1的位。如果找到了,返回该位的索引;如果没有找到,返回-1。

nextclearBit(int fromIndex):从 fromIndex 开始(包括 fromIndex本身)寻找下一个为0的位。如果找到了 返回该位的索引;如果没有找到,返回一个大的整数值。

使用 nextSetBit,可以跳过无意义的循环检查,通过位运算来获取被设置为1的位置,性能更高。

修改后的代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 public List<Integer> getUserSignInRecord (long userId, Integer year) { if (year == null ) { LocalDate date = LocalDate.now(); year = date.getYear(); } String key = RedisConstant.getUserSignInRedisKey(year, userId); RBitSet signInBitSet = redissonClient.getBitSet(key); BitSet bitSet = signInBitSet.asBitSet(); List<Integer> dayList = new ArrayList <>(); int index = bitSet.nextSetBit(0 ); while (index >= 0 ) { dayList.add(index); index = bitSet.nextSetBit(index + 1 ); } return dayList; }

优化小结 优化小结 本功能的性能优化也是有代表性的,总结出来几个实用优化思路:

减少网络请求或调用次数

减少接口传输数据的体积

减少循环和计算

通过客户端计算减少服务端的压力

前端开发 1、引入 ECharts 组件库

安装 ECharts:https://echarts.apache.org/zh/index.html1608639807578177538_0.43979611555120557

和 React ECharts 可视化库:https://github.com/hustcc/echarts-for-react

1 2 npm install --save echarts --force npm install --save echarts-for-react --force

2、用户中心页面开发

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 <Dropdown menu={{ items : [ { key : "userCenter" , icon : <UserOutlined /> label : "个人中心" , }, { key : "logout" , icon : <LogoutOutlined /> label : "退出登录" , }, ], onClick : async (event : { key : React .Key }) => { const { key } = event; if (key === "logout" ) { userLogout (); } else if (key === "userCenter" ) { router.push ("/user/center" ); } }, }} > {dom} </Dropdown >

页面结构可以通过如下组件快速完成:

栅格响应式布局:https://ant-design.antgroup.com/components/grid-cn#grid-demo-responsive 左侧用户信息,Card.Meta 组件:https://ant-design.antgroup.com/components/card-cn#card-demo-meta 右侧内容区域,带页签的卡片:https://ant-design.antgroup.com/components/card-cn#card-demo-tabs

3、封装日历组件

1)参考 React ECharts 的 官方文档 来使用 ECharts 组件,把 Demo 代码复制到新建的组件文件中。

2)在用户中心页面中引入组件,便于查看效果:

1 2 3 {activeTabKey === "record" && <> <CalendarChart /> </>

3)定义签到日期数组变量,将数组转换为图表需要的数据。其中,对日期的处理需要用到 dayjs 库:

1 2 3 4 5 6 7 8 9 10 11 12 const [dataList, setDataList] = useState<number []>([]);const year = new Date ().getFullYear ();const optionsData = dataList.map ((dayOfYear, index ) => { const dateStr = dayjs (`${year} -01-01` ) .add (dayOfYear - 1 , "day" ) .format ("YYYY-MM-DD" ); return [dateStr, 1 ]; });

4)参考 Echarts 的官方 Demo 开发前端日历图:https://echarts.apache.org/examples/zh/editor.html?c=calendar-simple

先在 Demo 页面里调整好效果,得到 options 选项。

调整好的 options 如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 const options = { visualMap : { show : false , min : 0 , max : 1 , inRange : { color : ["#efefef" , "lightgreen" ], }, }, calendar : { range : year, left : 20 , cellSize : ['auto' , 16 ], yearLabel : { position : "top" , formatter : `${year} 年刷题记录` , } }, series : { type : "heatmap" , coordinateSystem : "calendar" , data : optionsData, }, };

5)获取数据:前端调用 OpenAP| 生成新的刷题签到记录相关接口,调用并得到 dataList 即可。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 const fetchDataList = async ( try { const res = await getUserSignInRecordUsingGet ({ year, }); setDataList (res.data || []); } catch (e) { message.error ("获取刷题签到记录失败," + e.message ); } }; useEffect (() => { fetchDataList (); }, []);

4、执行签到

由于获取题目详情接口是在服务端渲染,拿不到用户登录态,所以建议在客户端额外发送请求来执行签到。

编写一个 hooks 钩子,便于在多个题目详情页中复用:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 import { useEffect, useState } from "react" ;import { message } from "antd" ;import { addUserSignInUsingPost } from "@/api/userController" ;const useAddUserSignInRecord = ( const [loading, setLoading] = useState (false ); const doFetch = async ( setLoading (true ); try { await addUserSignInUsingPost (); } catch (e) { message.error ("添加刷题签到记录失败," + e.message ); } finally { setLoading (false ); } }; useEffect (() => { doFetch (); }, []); return { loading }; }; export default useAddUserSignInRecord;

注意,该钩子需要在客户端组件中执行,因为用到了 useEffect 防止重复请求、并且还需要获取到用户登录态。

可以在题目详情卡片 QuestionCard 这一客户端组件里使用钩子,这样所有题目详情页都会触发签到。代码如下:

1 2 3 4 5 6 7 8 const QuestionCard = (props: Props ) => { const { question } = props; useAddUserSignInRecord (); }

前端拓展

1)用户中心是否需要实现服务端渲染?如何实现服务端渲染?思路:先通过 userld 获取基础信息(未登录也可获取),再到客户端携带 Cookie 获取登录用户可见的信息。

2)用户中心页面添加权限校验 思路:可以通过 menu 菜单项配置,利用全局权限校验实现仅登录用户可见。

3)优化:如果前端签到成功,可以保存到LocalStorage 等位置,防止每次刷题都重复发送签到请求。

拓展 1、过期时间

问:Redis 中的 Bitmap 如何设置过期时间?需要设置一年的过期时间吗?答:如果用户有看往年记录的需求,可以用单次任务(或定时任务)将往年 Redis 数据落库,确保入库成功后,清理Redis 即可。

比如 2025 年1月1号,就可以将 2024 年的签到记录入库了。 除非是非常重要的数据,否则最好还是设置下过期时间,一年多即可。

再问:Bitmap 一年落库一次吗?不怕数据丢失吗?

答:Redis 本身有持久化机制,虽然无法完全保证数据不丢失,但是至少数据不会全部丢失。根据我们的刷题逻辑,即使Redis 意外宕机,丢失前几秒的部分签到,但是用户当天刷题后又会补回来。

如果想保证数据完全不丢失,那么需要在获取题目详情的时候,同步将刷题记录落库,这样性能相对而言就比较差,在一些重要的数据场景需要这样设计。或者再加一个消息队列来提高性能,但架构复杂度和系统维护成本就更高了。

2、更详细的刷题记录

分词题目搜索 方案设计

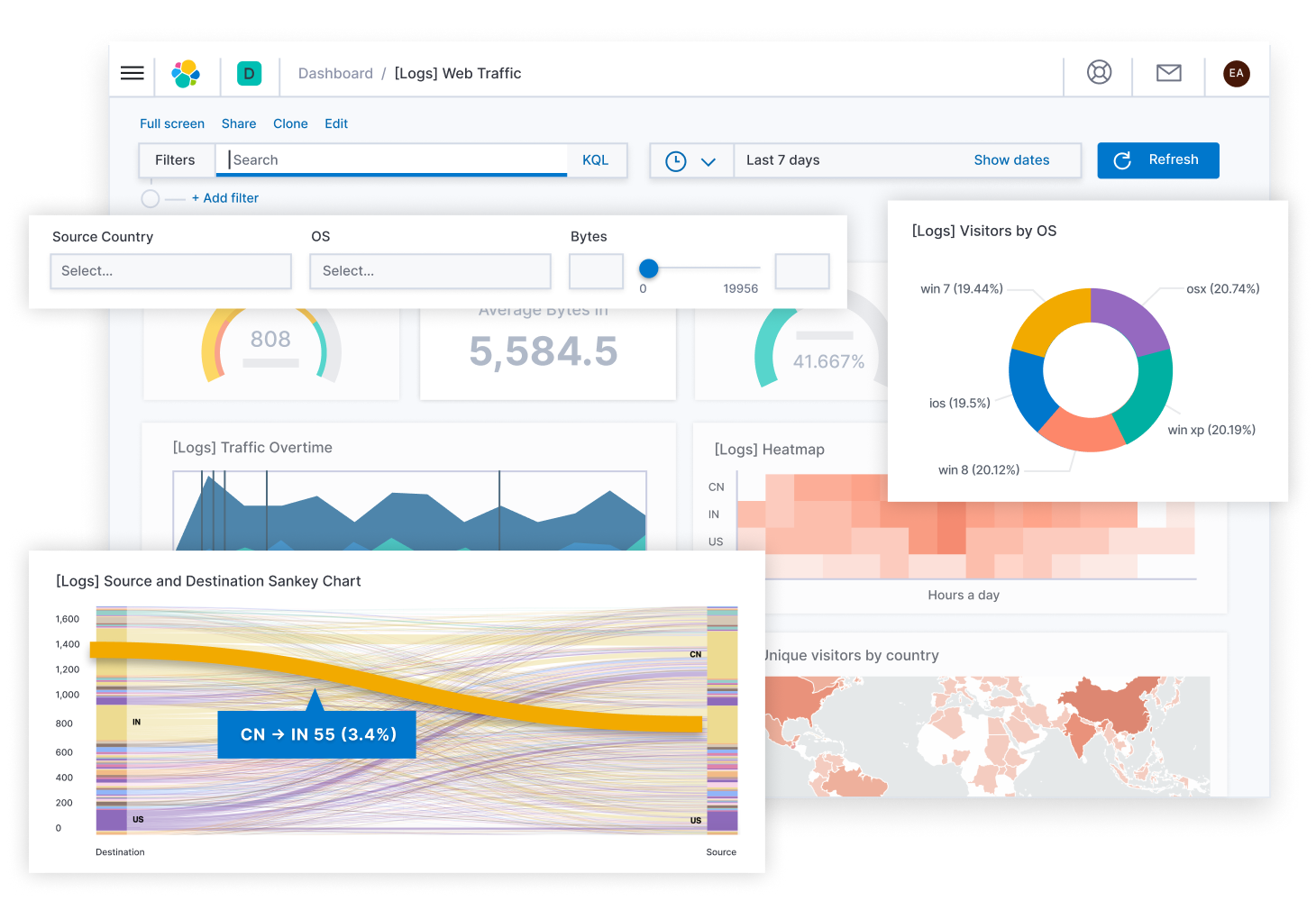

使用 Elasticsearch 实现题目数据的存储和分词搜索,需要将数据库的数据同步到 Elasticsearch。

1、什么是 ES

Elasticsearch 生态系统非常丰富,包含了一系列工具和功能,帮助用户处理、分析和可视化数据,Elastic Stack 是其核心组成部分。

2、ES 生态

Elasticsearch 生态系统非常丰富,包含了一系列工具和功能,帮助用户处理、分析和可视化数据,Elastic Stack 是其核心组成部分。

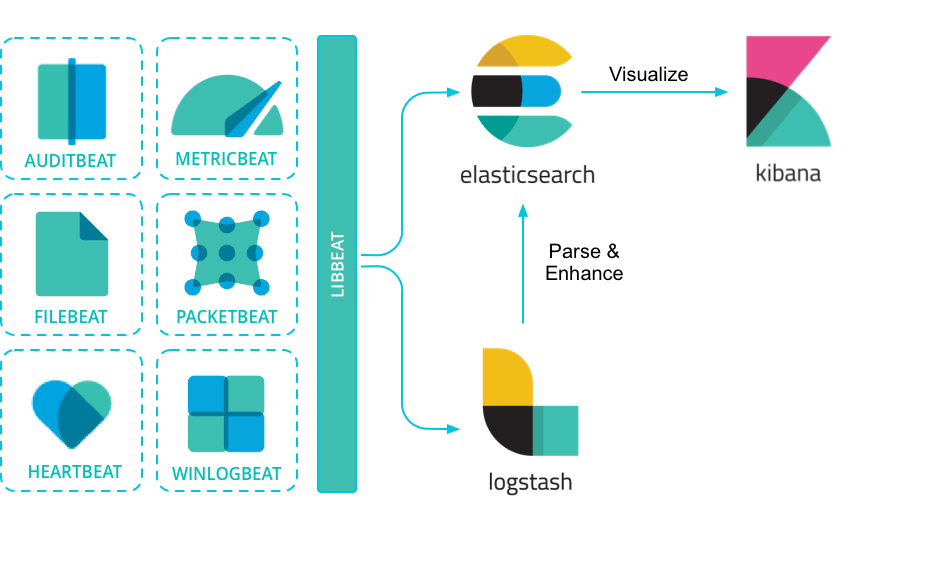

Elastic Stack(也称为 ELK Stack)由以下几部分组成:

Elasticsearch:核心搜索引擎,负责存储、索引和搜索数据。

Kibana:可视化平台,用于查询、分析和展示 Elasticsearch 中的数据。

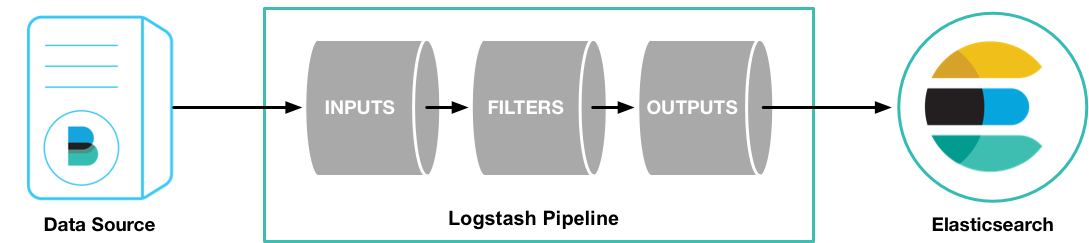

Logstash:数据处理管道,负责数据收集、过滤、增强和传输到 Elasticsearch。

Beats:轻量级的数据传输工具,收集和发送数据到 Logstash 或 Elasticsearch。

Kibana 是 Elastic Stack 的可视化组件,允许用户通过图表、地图和仪表盘来展示存储在 Elasticsearch 中的数据。它提供了简单的查询接口、数据分析和实时监控功能。

Logstash 是一个强大的数据收集管道工具,能够从多个来源收集、过滤、转换数据,然后将数据发送到 Elasticsearch。Logstash 支持丰富的输入、过滤和输出插件。

Beats 是一组轻量级的数据采集代理,负责从不同来源收集数据并发送到 Elasticsearch 或 Logstash。常见的 Beats 包括:

Filebeat:收集日志文件。

Metricbeat:收集系统和服务的指标。

Packetbeat:监控网络流量。

3、Elasticsearch 的核心概念

索引(Index):类似于关系型数据库中的表,索引是数据存储和搜索的 基本单位 。每个索引可以存储多条文档数据。

文档(Document):索引中的每条记录,类似于数据库中的行。文档以 JSON 格式存储。

字段(Field):文档中的每个键值对,类似于数据库中的列。

映射(Mapping):用于定义 Elasticsearch 索引中文档字段的数据类型及其处理方式,类似于关系型数据库中的 Schema 表结构,帮助控制字段的存储、索引和查询行为。

集群(Cluster):多个节点组成的群集,用于存储数据并提供搜索功能。集群中的每个节点都可以处理数据。

分片(Shard):为了实现横向扩展,ES 将索引拆分成多个分片,每个分片可以分布在不同节点上。

副本(Replica):分片的复制品,用于提高可用性和容错性。

和数据库类比:

Elasticsearch 概念 关系型数据库类比

Index

Table

Document

Row

Field

Column

Mapping

Schema

Shard

Partition

Replica

Backup

4、Elasticsearch 实现全文检索的原理

1)分词:Elasticsearch 的分词器会将输入文本拆解成独立的词条(tokens),方便进行索引和搜索。分词的具体过程包括以下几步:

字符过滤:去除特殊字符、HTML 标签或进行其他文本清理。

分词:根据指定的分词器(analyzer),将文本按规则拆分成一个个词条。例如,英文可以按空格拆分,中文使用专门的分词器处理。

词汇过滤:对分词结果进行过滤,如去掉停用词(常见但无意义的词,如 “the”、”is” 等)或进行词形归并(如将动词变为原形)。

Elasticsearch 内置了很多分词器,比如按照空格分词等,默认只支持英文,可以在 官方文档 了解。

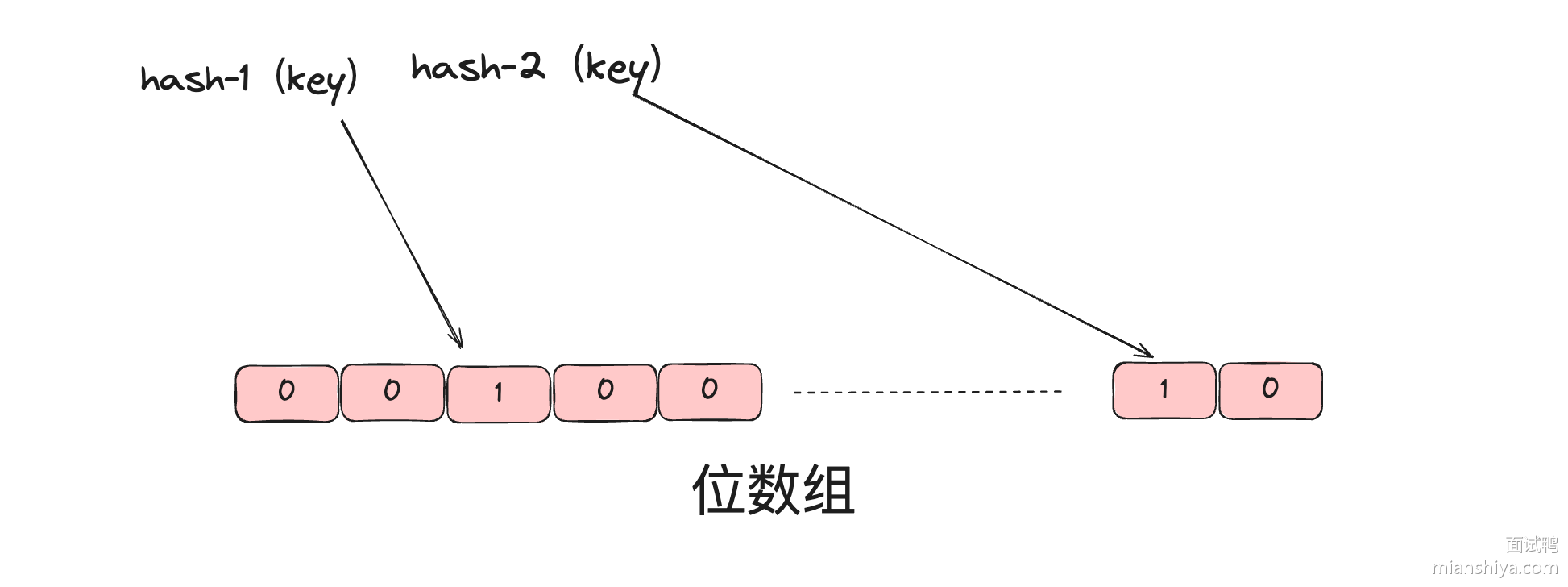

2)倒排索引:

倒排索引是 Elasticsearch 实现高效搜索的核心数据结构。它将文档中的词条映射到文档 ID,实现快速查找。

工作原理:

每个文档在被索引时,分词器会将文档内容拆解为多个词条。

然后,Elasticsearch 为每个词条生成一个倒排索引,记录该词条在哪些文档中出现。

举个例子,假设有两个文档:

中文分词后,生成的倒排索引大致如下:

词条

文档 ID

鱼皮

1, 2

是

1, 2

帅锅

1

好人

2

通过这种结构,查询某个词时,可以快速找到包含该词的所有文档。

5、Elasticsearch 打分规则

实际应用 Elasticsearch 来实现搜索功能时,我们不仅要求能搜到内容,而且还要把和用户搜索最相关的内容展示在前面。这就需要我们了解 Elasticsearch 的打分规则。

打分规则(Score)是用于衡量每个文档与查询条件的匹配度的评分机制。搜索结果的默认排序方式是按相关性得分( score)从高到低。Elasticsearch 使用 BM25 算法 来计算每个文档的得分,它是基于词频、反向文档频率、文档长度等因素来评估文档和查询的相关性。

打分的主要因素:

词频(TF, Term Frequency):查询词在文档中出现的次数,出现次数越多,得分越高。

反向文档频率(IDF, Inverse Document Frequency):查询词在所有文档中出现的频率。词在越少的文档中出现,IDF 值越高,得分越高。

文档长度:较短的文档往往被认为更相关,因为查询词在短文档中占的比例更大。

下面举一个例子:假设要在 Elasticsearch 中查询 鱼皮 这个关键词,索引中有以下三个文档:

文档 1:

1 2 3 plain 复制代码鱼皮是个帅小伙,鱼皮非常聪明,鱼皮很喜欢编程。

分析:

查询词 鱼皮 出现了 3 次。

该文档较短,查询词 鱼皮 的密度很高。

由于 鱼皮 在文档中多次出现且文档较短,因此得分较高,相关性较强。

文档 2:

分析:

尽管文档短,但是查询词出现的次数少,因此得分中等,相关性较普通。

文档 3:

1 2 3 plain 复制代码鱼皮是个帅小伙,他喜欢写代码。他的朋友们也很喜欢编程和技术讨论,大家经常一起参与各种技术会议,讨论分布式系统、机器学习和人工智能等主题。

分析:

查询词 鱼皮 出现了 1 次。

文档较长,且 鱼皮 只在文档开头出现,词条密度较低。

由于文档很长,鱼皮 出现的次数少,密度也低,因此得分较低,相关性不强。

再举个例子,什么是反向文档频率?

假如说 ES 中有 10 个文档,都包含了“鱼皮”这个关键词;只有 1 个文档包含了“帅锅”这个关键词。

现在用户搜索“鱼皮帅锅”,大概率会把后面这条文档搜出来,因为更稀有。

当然,以上只是简单举例,实际上 ES 计算打分规则时,会有一套较为复杂的公式,感兴趣的同学可以阅读下面资料来了解:

6、Elasticsearch 查询语法

Elasticsearch 支持多种查询语法,用于不同的场景和需求,主要包括查询 DSL、EQL、SQL 等。

*1)DSL 查询(* *Domain Specific Language* *) *

一种基于 JSON 的查询语言,它是 Elasticsearch 中最常用的查询方式。

示例:

1 2 3 4 5 6 7 json复制代码{ "query" : { "match" : { "message" : "Elasticsearch 是强大的" } } }

这个查询会对 message 字段进行分词,并查找包含 “Elasticsearch” 和 “强大” 词条的文档。

2)EQL

EQL 全称 Event Query Language,是一种用于检测和检索时间序列 事件 的查询语言,常用于日志和安全监控场景。

示例:查找特定事件

1 2 3 plain 复制代码process where process.name == "malware.exe"

这个查询会查找 process.name 为 “malware.exe” 的所有进程事件,常用于安全检测中的恶意软件分析。

3)SQL 查询

Elasticsearch 提供了类似于传统数据库的 SQL 查询语法,允许用户以 SQL 的形式查询 Elasticsearch 中的数据,对熟悉 SQL 的用户来说非常方便。

示例 SQL 查询:

1 2 3 sql 复制代码SELECT name, age FROM users WHERE age > 30 ORDER BY age DESC

这个查询会返回 users 索引中 age 大于 30 的所有用户,并按年龄降序排序。

以下几种简单了解即可:

4)Lucene 查询语法

Lucene 是 Elasticsearch 底层的搜索引擎,Elasticsearch 支持直接使用 Lucene 的查询语法,适合简单的字符串查询。

示例 Lucene 查询:

1 2 3 plain 复制代码name:Elasticsearch AND age:[30 TO 40]

这个查询会查找 name 字段为 “Elasticsearch” 且 age 在 30 到 40 之间的文档。

5)Kuery(KQL: Kibana Query Language)

KQL 是 Kibana 的查询语言,专门用于在 Kibana 界面上执行搜索查询,常用于仪表盘和数据探索中。

示例 KQL 查询:

1 2 3 plain 复制代码name: "Elasticsearch" and age > 30

这个查询会查找 name 为 “Elasticsearch” 且 age 大于 30 的文档。

6)Painless 脚本查询

Painless 是 Elasticsearch 的内置脚本语言,用于执行自定义的脚本操作,常用于排序、聚合或复杂计算场景。

示例 Painless 脚本:

1 2 3 4 5 6 7 8 9 10 11 12 json复制代码{ "query" : { "script_score" : { "query" : { "match" : { "message" : "Elasticsearch" } } , "script" : { "source" : "doc['popularity'].value * 2" } } } }

这个查询会基于 popularity 字段的值进行动态评分,将其乘以 2。

总结一下,DSL 是最通用的,EQL 和 KQL 则适用于特定场景,如日志分析和 Kibana 查询,而 SQL 则便于数据库开发人员上手。

7、Elasticsearch 查询条件

如何利用 Elasticsearch 实现数据筛选呢?需要了解其查询条件,以 ES 的 DSL 语法为例:

查询条件 介绍 示例 用途

match用于全文检索,将查询字符串进行分词并匹配文档中对应的字段。

{ "match": { "content": "鱼皮是帅小伙" } }适用于全文检索,分词后匹配文档内容。

term精确匹配查询,不进行分词。通常用于结构化数据的精确匹配,如数字、日期、关键词等。

{ "term": { "status": "active" } }适用于字段的精确匹配,如状态、ID、布尔值等。

terms匹配多个值中的任意一个,相当于多个 term 查询的组合。

{ "terms": { "status": ["active", "pending"] } }适用于多值匹配的场景。

range范围查询,常用于数字、日期字段,支持大于、小于、区间等查询。

{ "range": { "age": { "gte": 18, "lte": 30 } } }适用于数值或日期的范围查询。

bool组合查询,通过 must、should、must_not 等组合多个查询条件。

{ "bool": { "must": [ { "term": { "status": "active" } }, { "range": { "age": { "gte": 18 } } } ] } }适用于复杂的多条件查询,可以灵活组合。

wildcard通配符查询,支持 * 和 ?,前者匹配任意字符,后者匹配单个字符。

{ "wildcard": { "name": "鱼*" } }适用于部分匹配的查询,如模糊搜索。

prefix前缀查询,匹配以指定前缀开头的字段内容。

{ "prefix": { "name": "鱼" } }适用于查找以指定字符串开头的内容。

fuzzy模糊查询,允许指定程度的拼写错误或字符替换。

{ "fuzzy": { "name": "yupi~2" } }适用于处理拼写错误或不完全匹配的查询。

exists查询某字段是否存在。

{ "exists": { "field": "name" } }适用于查找字段存在或缺失的文档。

match_phrase短语匹配查询,要求查询的词语按顺序完全匹配。

{ "match_phrase": { "content": "鱼皮 帅小伙" } }适用于严格的短语匹配,词语顺序和距离都严格控制。

match_all匹配所有文档。

{ "match_all": {} }适用于查询所有文档,通常与分页配合使用。

ids基于文档 ID 查询,支持查询特定 ID 的文档。

{ "ids": { "values": ["1", "2", "3"] } }适用于根据文档 ID 查找特定文档。

geo_distance地理位置查询,基于地理坐标和指定距离查询。

{ "geo_distance": { "distance": "12km", "location": { "lat": 40.73, "lon": -74.1 } } }适用于根据距离计算查找地理位置附近的文档。

aggregations聚合查询,用于统计、计算和分组查询,类似 SQL 中的 GROUP BY。

{ "aggs": { "age_stats": { "stats": { "field": "age" } } } }适用于统计和分析数据,比如求和、平均值、最大值等。

其中的几个关键:

精确匹配 vs. 全文检索:term 是精确匹配,不分词;match 用于全文检索,会对查询词进行分词。

组合查询:bool 查询可以灵活组合多个条件,适用于复杂的查询需求。

模糊查询:fuzzy 和 wildcard 提供了灵活的模糊匹配方式,适用于拼写错误或不完全匹配的场景。

了解上面这些一般就足够了,更多可以随用随查,参考 官方文档 。

8、Elasticsearch 客户端

前面了解了 Elasticsearch 的概念和查询语法,但是如何执行 Elasticsearch 操作呢?还需要了解下 ES 的客户端,列举一些常用的:

1)HTTP API:Elasticsearch 提供了 RESTful HTTP API,用户可以通过直接发送 HTTP 请求来执行索引、搜索和管理集群的操作。官方文档

2)Kibana:Kibana 是 Elasticsearch 官方提供的可视化工具,用户可以通过 Kibana 控制台使用查询语法(如 DSL、KQL)来执行搜索、分析和数据可视化。

3)Java REST Client:Elasticsearch 官方提供的 Java 高级 REST 客户端库,用于 Java 程序中与 Elasticsearch 进行通信,支持索引、查询、集群管理等操作。官方文档

4)Spring Data Elasticsearch:Spring 全家桶的一员,用于将 Elasticsearch 与 Spring 框架集成,通过简化的 Repository 方式进行索引、查询和数据管理操作。官方文档

5)Elasticsearch SQL CLI:命令行工具,允许通过类 SQL 语法直接在命令行中查询 Elasticsearch 数据,适用于熟悉 SQL 的用户。

此外,Elasticsearch 当然不只有 Java 的客户端,Python、PHP、Node.js、Go 的客户端都是支持的。

💡 在选择客户端时,要格外注意版本号!!!要跟 Elasticsearch 的版本保持兼容。

9、ES 数据同步方案

一般情况下,如果做查询搜索功能,使用 ES 来模糊搜索,但是数据是存放在数据库 MySQL 里的,所以说我们需要把 MySQL 中的数据和 ES 进行同步,保证数据一致(以 MySQL 为主)。

数据流向:MySQL => ES (单向)

数据同步一般有 2 个过程:全量同步(首次)+ 增量同步(新数据)

总共有 4 种主流方案:

1)定时任务

比如 1 分钟 1 次,找到 MySQL 中过去几分钟内(至少是定时周期的 2 倍)发生改变的数据,然后更新到 ES。

优点:

简单易懂,开发、部署、维护相对容易。

占用资源少,不需要引入复杂的第三方中间件。

不用处理复杂的并发和实时性问题。

缺点:

有时间差 :无法做到实时同步,数据存在滞后。数据频繁变化时,无法确保数据完全同步,容易出现错过更新的情况。

对大数据量的更新处理不够高效,可能会引入重复更新逻辑。

应用场景:

数据实时性要求不高:适合数据短时间内不同步不会带来重大影响的场景。

数据基本不发生修改:适合数据几乎不修改、修改不频繁的场景。

数据容忍丢失

2)双写

写数据的时候,必须也去写 ES;更新删除数据库同理。

可以通过事务保证数据一致性,使用事务时,要先保证 MySQL 写成功,因为如果 ES 写入失败了,不会触发回滚,但是可以通过定时任务 + 日志 + 告警进行检测和修复(补偿)。

优点:

方案简单易懂,业务逻辑直接控制数据同步。

可以利用事务部分保证 MySQL 和 ES 的数据一致性。

同步的时延较短,理论上可以接近实时更新 ES。

缺点:

影响性能 :每次写 MySQL 时,需要同时操作 ES,增加了业务写入延迟,影响性能。一致性问题 :如果 ES 写入失败,MySQL 事务提交成功后,ES 可能会丢失数据;或者 ES 写入成功,MySQL 事务提交失败,ES 无法回滚。因此必须额外设计监控、补偿机制来检测同步失败的情况(如通过定时任务、日志和告警修复)。代码复杂度增加,需要对每个写操作都进行双写处理。

应用场景:

实时性要求较高

业务写入频率较低:适合写操作不频繁的场景,这样对性能的影响较小。

3)用 Logstash 数据同步管道

一般要配合 kafka 消息队列 + beats 采集器:

优点:

配置驱动 :基于配置文件,减少了手动编码,数据同步逻辑和业务代码解耦。扩展性好 :可以灵活引入 Kafka 等消息队列实现异步数据同步,并可处理高吞吐量数据。支持多种数据源:Logstash 支持丰富的数据源,方便扩展其他同步需求。

缺点:

灵活性差 :需要通过配置文件进行同步,复杂的业务逻辑可能难以在配置中实现,无法处理细粒度的定制化需求。引入额外组件,维护成本高:通常需要引入 Kafka、Beats 等第三方组件,增加了系统的复杂性和运维成本。

应用场景:

大数据同步 :适合大规模、分布式数据同步场景。对实时性要求不高 :适合数据流处理或延迟容忍较大的系统。系统已有 Kafka 或类似的消息队列架构:如果系统中已经使用了 Kafka 等中间件,使用 Logstash 管道会变得很方便。

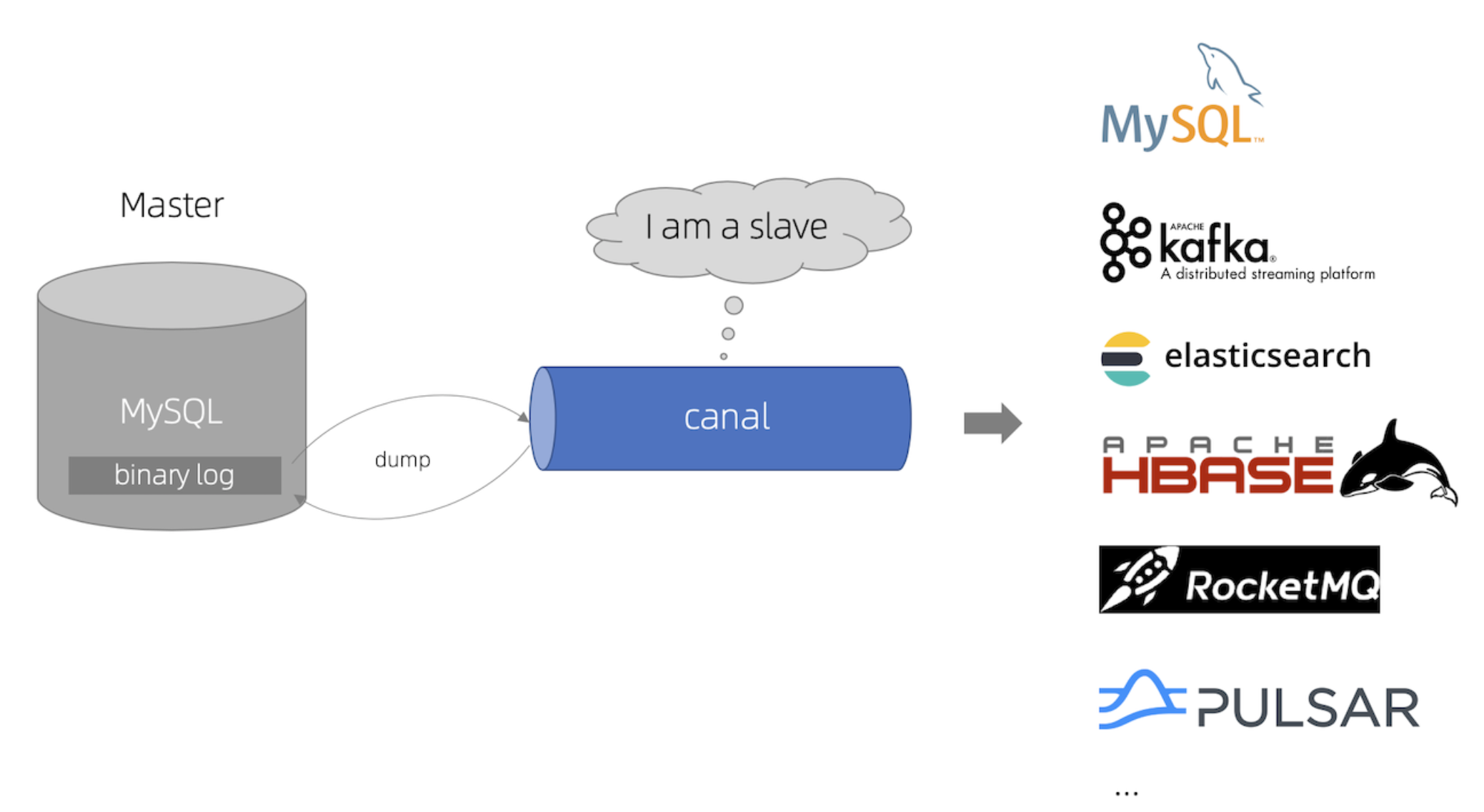

4)监听 MySQL Binlog

有任何数据变更时都能够实时监听到,并且同步到 Elasticsearch。一般不需要自己监听,可以使用现成的技术,比如 Canal 。

💡 Canal 的核心原理:数据库每次修改时,会修改 binlog 文件,只要监听该文件的修改,就能第一时间得到消息并处理

优点:

实时性强 :能够在 MySQL 数据发生变更的第一时间同步到 ES,做到真正的实时同步。轻量级:Binlog 是数据库自带的日志功能,不需要修改核心业务代码,只需要新增监听逻辑。

缺点:

引入外部依赖:需要引入像 Canal 这样的中间件,增加了系统的复杂性和维护成本。

运维难度增加:需要确保 Canal 或者其他 Binlog 监听器的稳定运行,并且对 MySQL 的 Binlog 配置要求较高。

一致性问题:如果 Canal 服务出现问题或暂停,数据可能会滞后或丢失,必须设计补偿机制。

应用场景:

实时同步要求高 :适合需要实时数据同步的场景,通常用于高并发、高数据一致性要求的系统。数据频繁变化 :适合数据变更频繁且需要高效增量同步的场景。

最终方案:对于本项目,由于数据量不大,题目更新也不频繁,容忍丢失和不一致,所以选用方案一,实现成本最低。

后端开发(ES 实战) 1、Elasticsearch 搭建 目标:安装 Elasticsearch 和 Kibana,能够在 Kibana 查看到 Elasticsearch 存储的数据。

💡 也可以直接使用云 Elasticsearch 服务,省去自主搭建的时间,推荐使用 Serverless 版本,学完关掉就行。

Elasticsearch 更新迭代非常快,所以安装时,一定要注意慎重选择版本号!

由于我们自己的项目用的 Spring Boot 2.7.6 版本,对应的 Spring Data Elasticsearch 客户端版本是 4.x,支持的 Elasticsearch 是 7.x,所以建议 Elasticsearch 使用 7.x 的版本。

安装版本为 7.17.24

💡 可以在 官方文档 了解到版本兼容情况:比如 Spring 6 才支持 Elasticsearch 8.x

1)安装 Elasticsearch(9200 端口) 参考官方文档:https://www.elastic.co/guide/en/elasticsearch/reference/7.17/setup.html

Windows 解压安装:https://www.elastic.co/guide/en/elasticsearch/reference/7.17/zip-windows.html

其他操作系统安装:https://www.elastic.co/guide/en/elasticsearch/reference/7.17/targz.html

如果官网下不动,可以用鱼皮已经下载好的:https://pan.baidu.com/s/1u73-Nlolrs8Rzb1_b6X6HA ,提取码:c2sd

注意,安装路径不要包含中文!

安装完成后进入 es 目录并执行启动命令(或者进入 bin 目录点击运行 elasticsearch.bat 程序):

可以用 CURL 测试是否启动成功:

1 复制代码curl -X GET "localhost:9200/?pretty"

2)安装 Kibana(5601 端口) 注意,只要是同一套技术,所有版本必须一致!此处都用 7.17 版本!

参考官方文档:https://www.elastic.co/guide/en/kibana/7.17/introduction.html

安装 Kibana:https://www.elastic.co/guide/en/kibana/7.17/install.html

安装完成后进入 kibana 目录并执行启动命令:

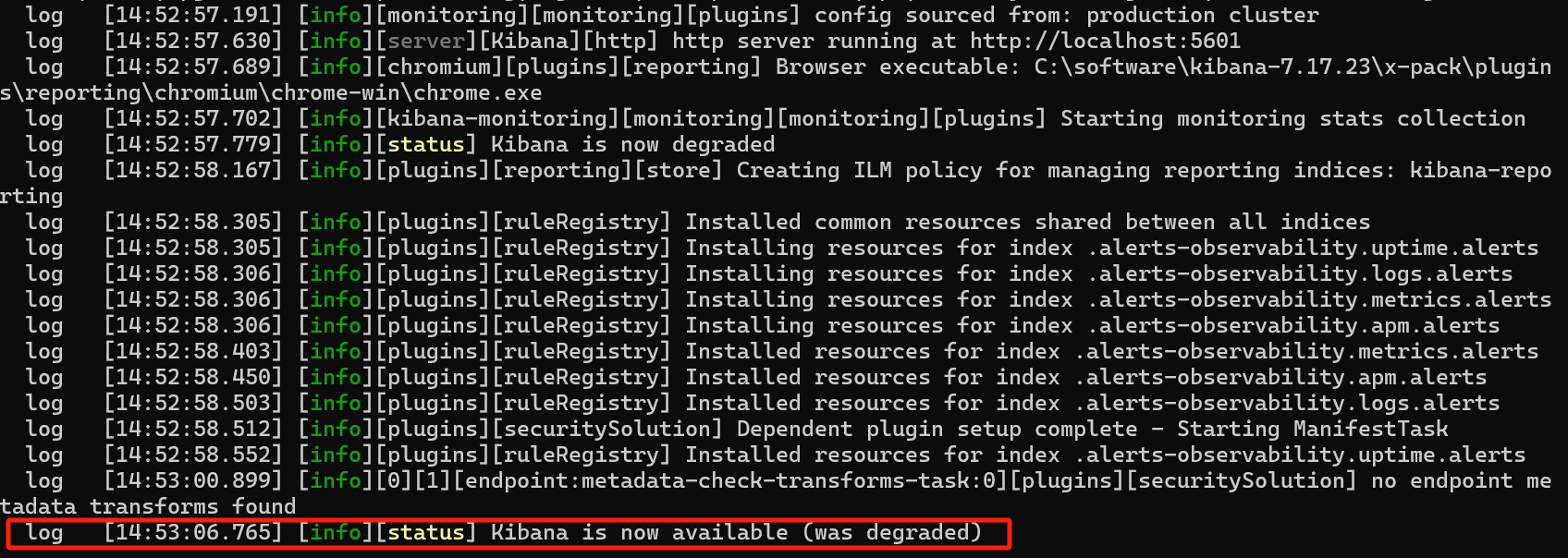

正常输出如图:

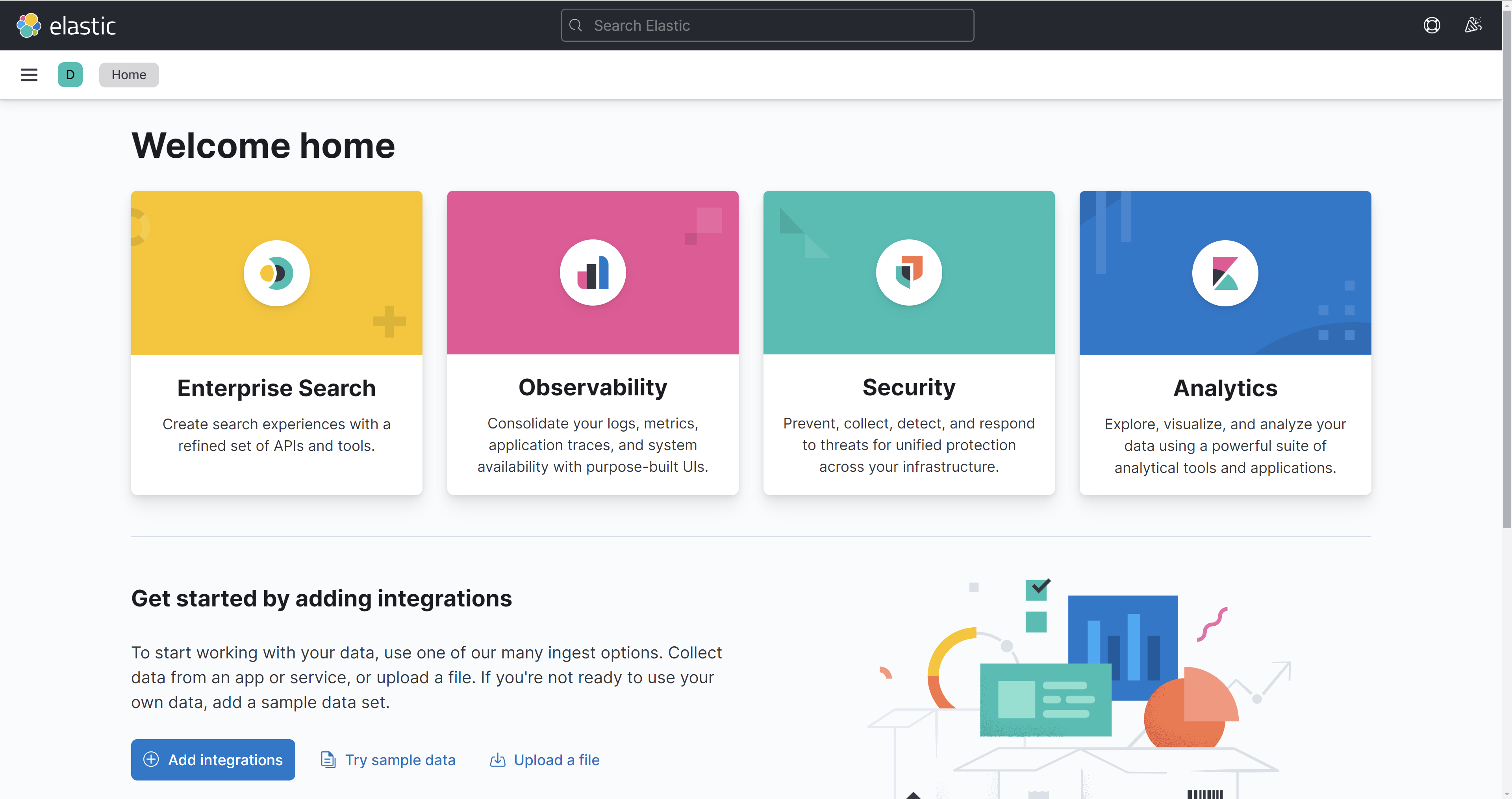

访问 http://localhost:5601/,即可开始使用。

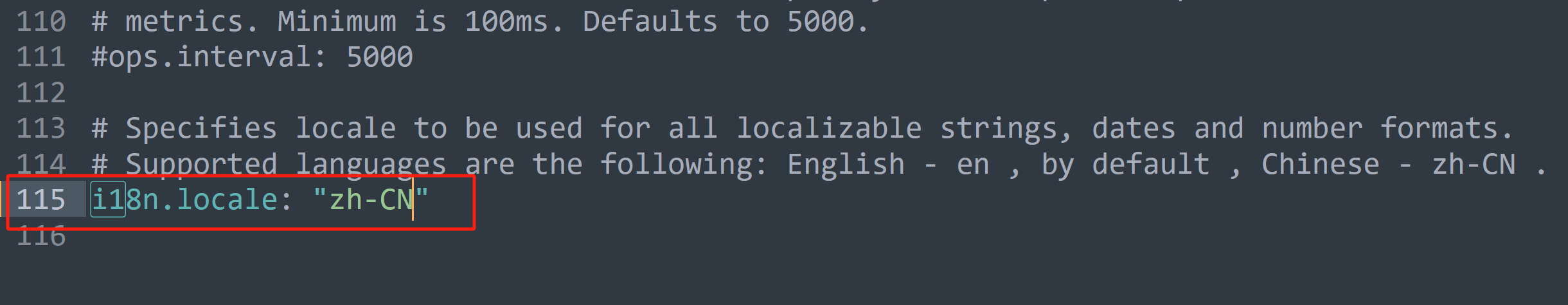

配置中文界面

但 kibana 默认是英文,不变阅读,可以修改 config/kibana.yml 中的国际化配置:

然后重启 kibana 即可。

注意,目前 Kibana 面板没有增加权限校验,所有人都能访问,所以请勿在线上直接部署!

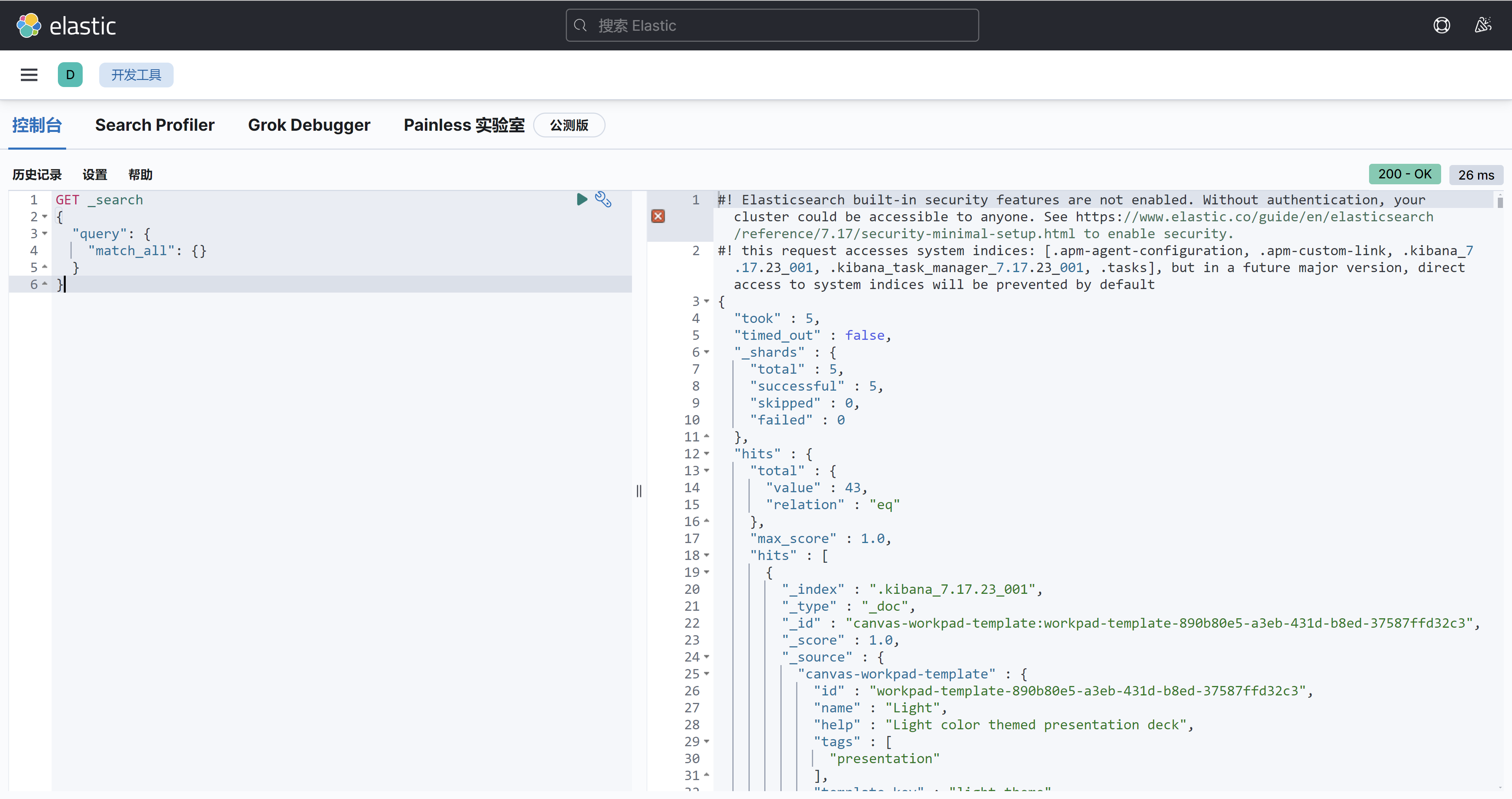

3)测试 尝试利用 Kibana 的开发工具来操作 Elasticsearch 的数据,比如查询:

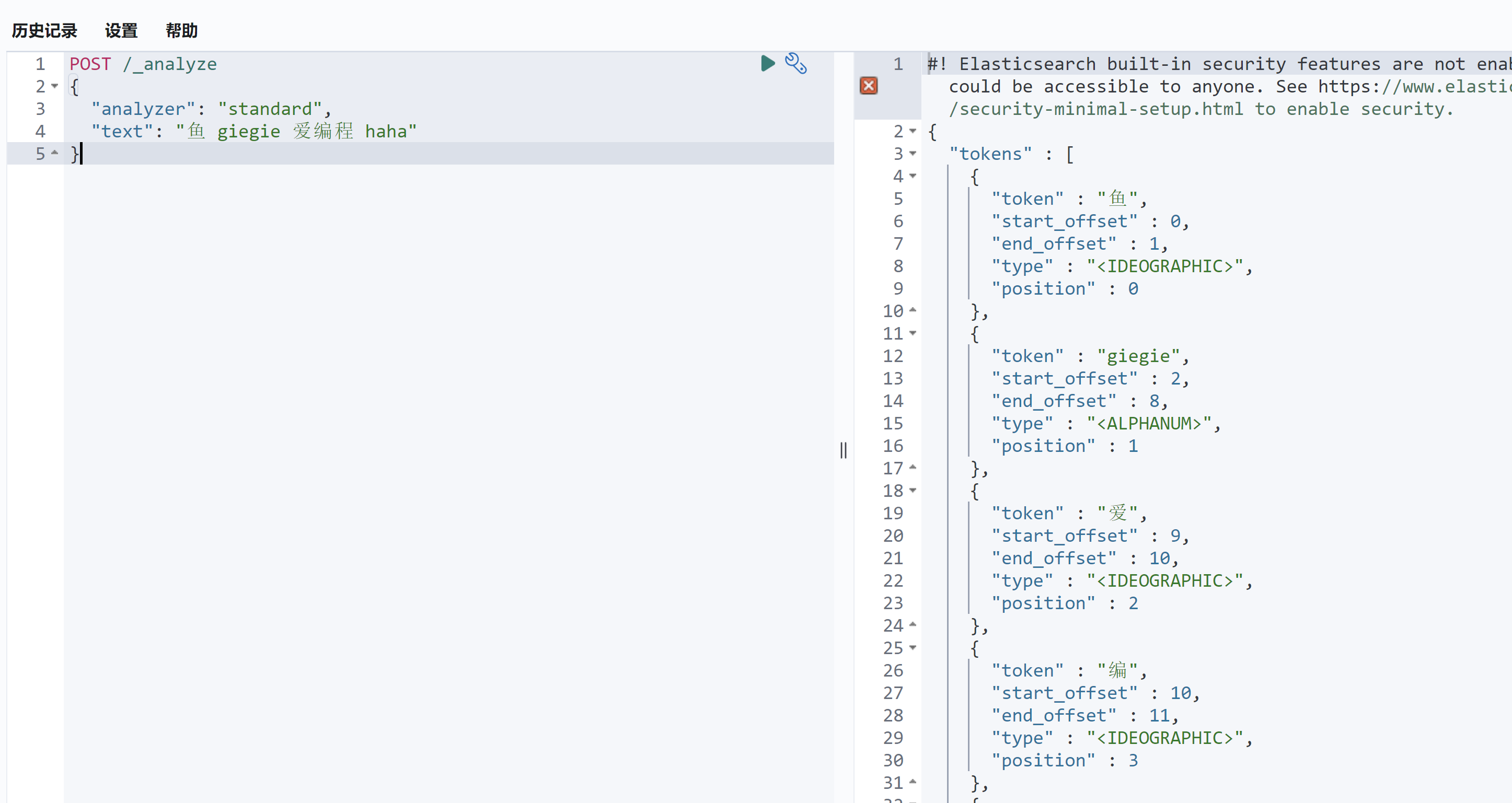

验证下分词器的效果,比如使用标准分词器:

1 2 3 4 5 POST /_analyze { "analyzer" : "standard" , "text" : "鱼皮是个帅小伙,非常喜欢编程" }

效果如图,英文被识别为了一个词,但中文未被识别:

默认支持的分词器如下:

standard:标准分词器。

simple:简单分词器。

whitespace:按空格分词。

stop:带停用词的分词器。

keyword:不分词,将整个字段作为一个词条。

pattern:基于正则表达式的分词器。

ngram 和 edge_ngram:n-gram 分词器。

由于这些分词器都不支持中文,所以需要安装 IK 中文分词器,以满足我们的业务需要。

4)安装 IK 中文分词器(ES 插件) 开源地址:https://github.com/medcl/elasticsearch-analysis-ik

直接按照官方指引安装即可,注意下载和我们 Elasticsearch 一致的版本,可以在这里找到各版本的插件包:https://release.infinilabs.com/analysis-ik/stable/

在 ES 安装目录下执行:

1 .\bin\elasticsearch-plugin.bat install https://release.infinilabs.com/analysis-ik/stable/elasticsearch-analysis-ik-7.17.24.zip

安装成功,需要重启 ES:

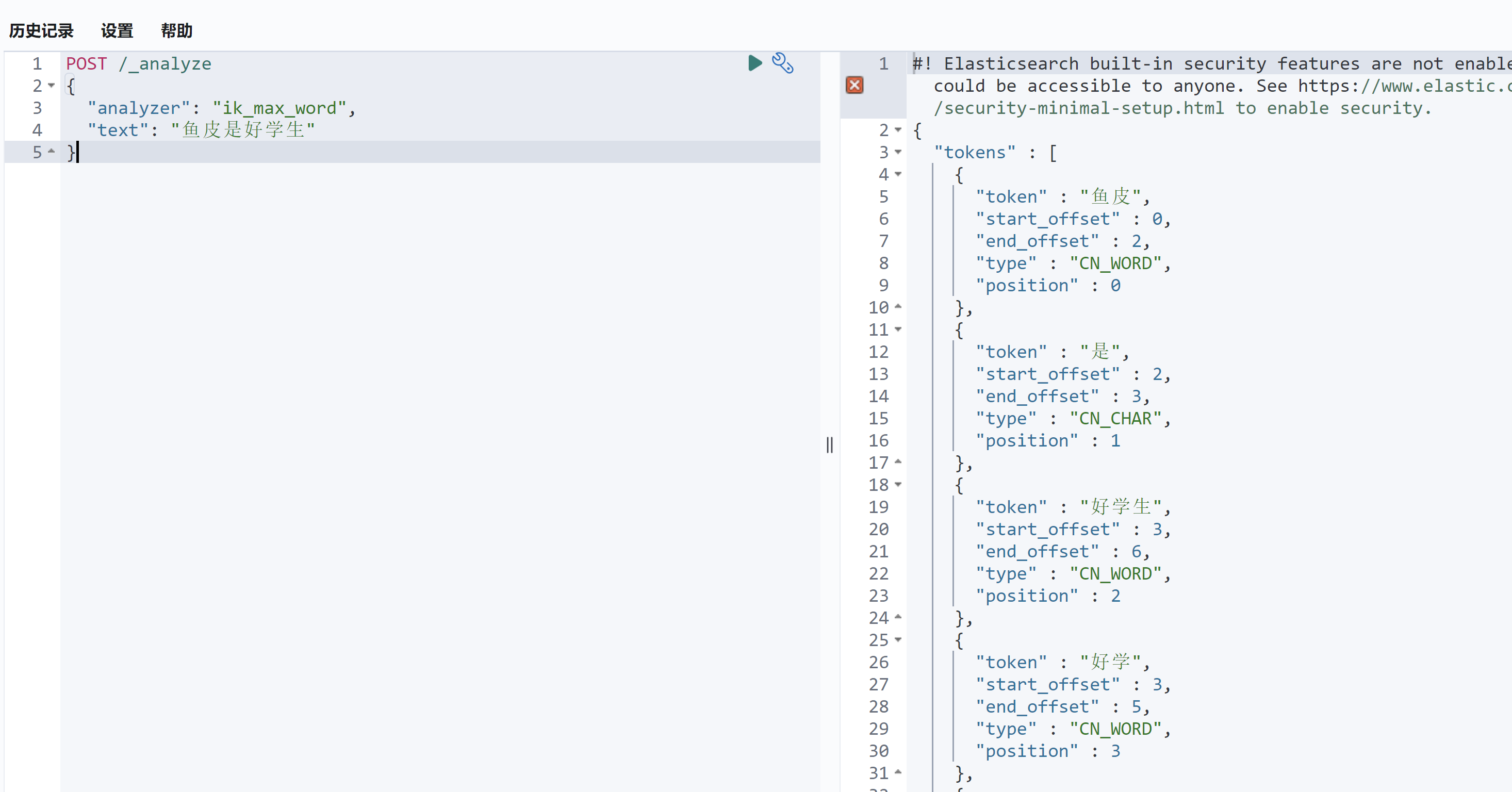

IK 分词器插件为我们提供了两个分词器:ik_smart 和 ik_max_word。

ik_smart 是智能分词 ,尽量选择最像一个词的拆分方式,比如“好学生”会被识别为一个词

ik_max_word 尽可能地分词 ,可以包括组合词,比如“好学生”会被识别为 3 个词:好学生、好学、学生

测试一下:

1 2 3 4 5 POST /_analyze { "analyzer": "ik_smart", "text": "鱼皮是好学生" }

如图:

这两种分词器如何选用呢?其实可以结合:

ik_smart:适用于 搜索分词 ,即在查询时使用,保证性能的同时提供合理的分词精度。ik_max_word:适用于 底层索引分词 ,确保在建立索引时尽可能多地分词,提高查询时的匹配度和覆盖面。

下面就来实战下 ES 索引的设计吧~

💡 思考:有些时候 IK 识别词汇不准,比如不认识“程序员鱼皮”,怎么样让 IK 按自己的规则分词?

解决方案:插件支持自定义词典。可以按照 官方文档 配置。

2、设计 ES 索引 为了将 MySQL 题目表数据导入到 Elasticsearch 中并实现分词搜索,需要为 ES 索引定义 mapping。ES 的 mapping 用于定义字段的类型、分词器及其索引方式。

相当于数据库的建表,数据库建表时我们要考虑索引,同样 Elasticsearch 建立索引时,要考虑到字段选取、分词器、字段格式等问题。

基于我们数据库的表结构和需求,我们可以定义 title、content、answer 等字段使用分词搜索,同时为其他字段指定适当的类型。以下是本项目的 mapping 定义:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 { "mappings" : { "properties" : { "title" : { "type" : "text" , "analyzer" : "ik_max_word" , "search_analyzer" : "ik_smart" , "fields" : { "keyword" : { "type" : "keyword" , "ignore_above" : 256 } } } , "content" : { "type" : "text" , "analyzer" : "ik_max_word" , "search_analyzer" : "ik_smart" } , "tags" : { "type" : "keyword" } , "answer" : { "type" : "text" , "analyzer" : "ik_max_word" , "search_analyzer" : "ik_smart" } , "userId" : { "type" : "long" } , "editTime" : { "type" : "date" , "format" : "yyyy-MM-dd HH:mm:ss" } , "createTime" : { "type" : "date" , "format" : "yyyy-MM-dd HH:mm:ss" } , "updateTime" : { "type" : "date" , "format" : "yyyy-MM-dd HH:mm:ss" } , "isDelete" : { "type" : "keyword" } } } }

为什么不显示指定 id 字段?

在 Elasticsearch 中,每个文档都有一个唯一的 _id 字段来标识文档,该字段用于文档的主键索引和唯一标识。通常,开发者并不需要显式定义 id 字段,因为 Elasticsearch 会自动生成 _id,或者在插入数据时,你可以手动指定 _id。

由于 _id 是 Elasticsearch 内部的系统字段,它默认存在并作为主键使用,因此在 mappings 中通常不需要显式定义。如果你想让某个字段(如 userId 或其他唯一标识)作为 _id,可以在插入文档时指定该字段的值作为 _id。比如:

1 2 3 4 5 PUT /index/_doc/<custom_id> { "userId" : 1001, "title" : "Example" }

日期字段为什么要格式化?

日期字段的格式化(format: "yyyy-MM-dd HH:mm:ss")有以下几个考虑:

一致性:定义日期字段的格式可以确保所有插入的日期数据都是一致的,避免因不同的日期格式导致解析错误。例如,Elasticsearch 默认可以支持多种日期格式,但如果不定义明确的格式,可能会导致不一致的日期解析。

优化查询:格式化日期后,Elasticsearch 知道该如何存储和索引这些时间数据,从而可以高效地执行基于日期的范围查询、过滤和排序操作。明确的格式定义还可以帮助 Elasticsearch 进行更优化的存储和压缩。

避免歧义:没有明确格式的日期可能导致歧义,比如 "2023-09-03" 是日期,还是年份?加上时间部分(如 "yyyy-MM-dd HH:mm:ss")可以更明确地表明时间的精度,便于进行更精确的查询。

tags 支持数组么?为什么

在 Elasticsearch 中,所有的字段类型(包括 keyword 和 text)默认都支持数组。你可以直接插入一个包含多个值的数组,Elasticsearch 会自动将其视为多个值的集合。例如,以下文档中,tags 字段是一个数组:

1 2 3 4 { "title" : "How to learn Elasticsearch" , "tags" : [ "Elasticsearch" , "Search" , "Database" ] }

在查询时,Elasticsearch 会将数组中的每个值视为独立的 keyword,可以进行精确匹配。

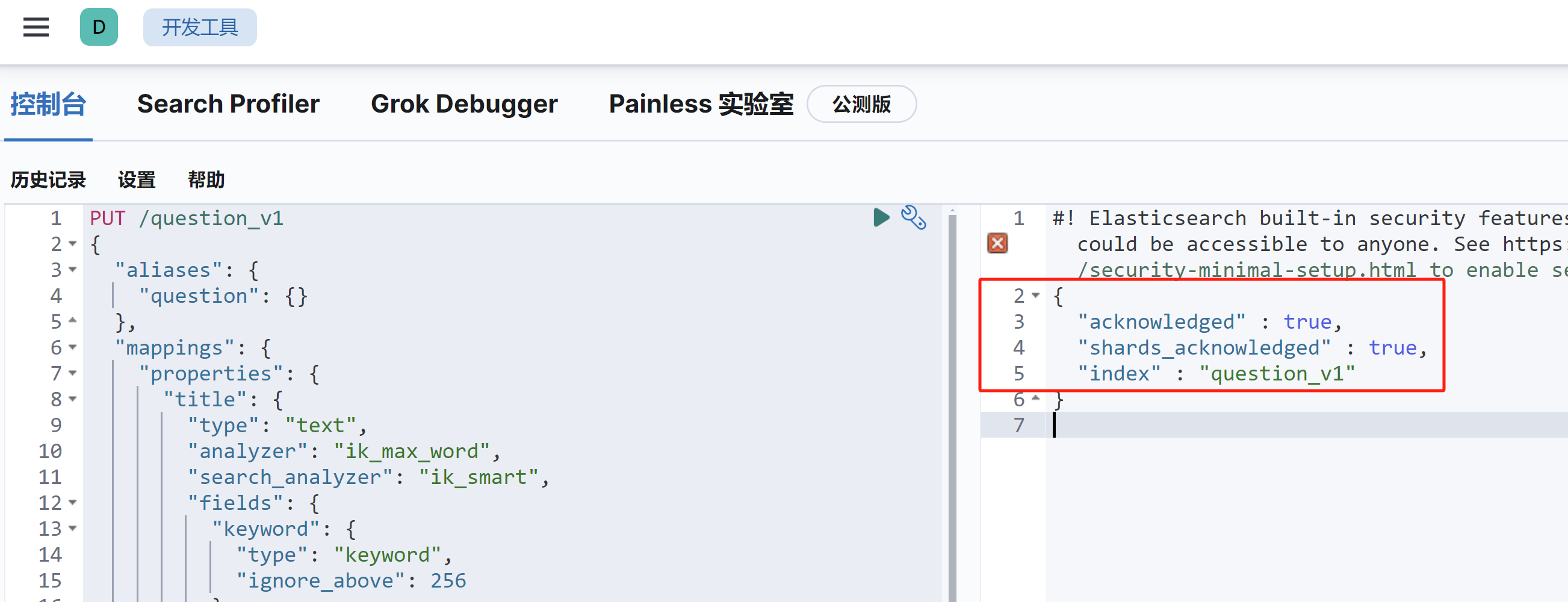

3、新建索引 可以通过如下命令创建索引,在 Kibana 开发者工具中执行、或者用 CURL 调用 Elasticsearch 执行均可:可以通过如下命令创建索引,在 Kibana 开发者工具中执行、或者用 CURL 调用 Elasticsearch 执行均可:

1 2 3 4 5 6 7 8 PUT /question_v1 { "mappings" : { "properties" : { ... } } }

但是有一点要注意,推荐在创建索引时添加 alias(别名) ,因为它提供了灵活性和简化索引管理的能力。具体原因如下:

零停机切换索引:在更新索引或重新索引数据时,你可以创建一个新索引并使用 alias 切换到新索引,而不需要修改客户端查询代码,避免停机或中断服务。

简化查询:通过 alias,可以使用一个统一的名称进行查询,而不需要记住具体的索引名称(尤其当索引有版本号或时间戳时)。

索引分组:alias 可以指向多个索引,方便对多个索引进行联合查询,例如用于跨时间段的日志查询或数据归档。

其中,第一个是重点,举个例子,在创建索引时添加 alias:

1 2 3 4 5 6 PUT /my_index_v1 { "aliases": { "my_index": {} } }

这个 alias 可以在后续版本中指向新的索引(如 my_index_v2),无需更改查询逻辑,查询时仍然使用 my_index。

所以,我们要执行的完整命令如下,可以放到后端项目目录中进行备份:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 PUT /question_v1 { "aliases": { "question": {} }, "mappings": { "properties": { "title": { "type": "text", "analyzer": "ik_max_word", "search_analyzer": "ik_smart", "fields": { "keyword": { "type": "keyword", "ignore_above": 256 } } }, "content": { "type": "text", "analyzer": "ik_max_word", "search_analyzer": "ik_smart" }, "tags": { "type": "keyword" }, "answer": { "type": "text", "analyzer": "ik_max_word", "search_analyzer": "ik_smart" }, "userId": { "type": "long" }, "editTime": { "type": "date", "format": "yyyy-MM-dd HH:mm:ss" }, "createTime": { "type": "date", "format": "yyyy-MM-dd HH:mm:ss" }, "updateTime": { "type": "date", "format": "yyyy-MM-dd HH:mm:ss" }, "isDelete": { "type": "keyword" } } } }

执行以上命令创建索引,创建成功的样子如下所示 :

4、引入 ES 客户端 1)引入依赖

1 2 3 4 5 <dependency > <groupId > org.springframework.boot</groupId > <artifactId > spring-boot-starter-data-elasticsearch</artifactId > </dependency >

2)更改 yml 配置

1 2 3 4 elasticsearch: uris: http://localhost:9200 username: root password: 123456

3)使用 spring data es 提供的 Bean 即可操作 Bean,可以直接通过 @Resource 注解注入

1 2 @Resource private ElasticsearchRestTemplate elasticsearchRestTemplate;

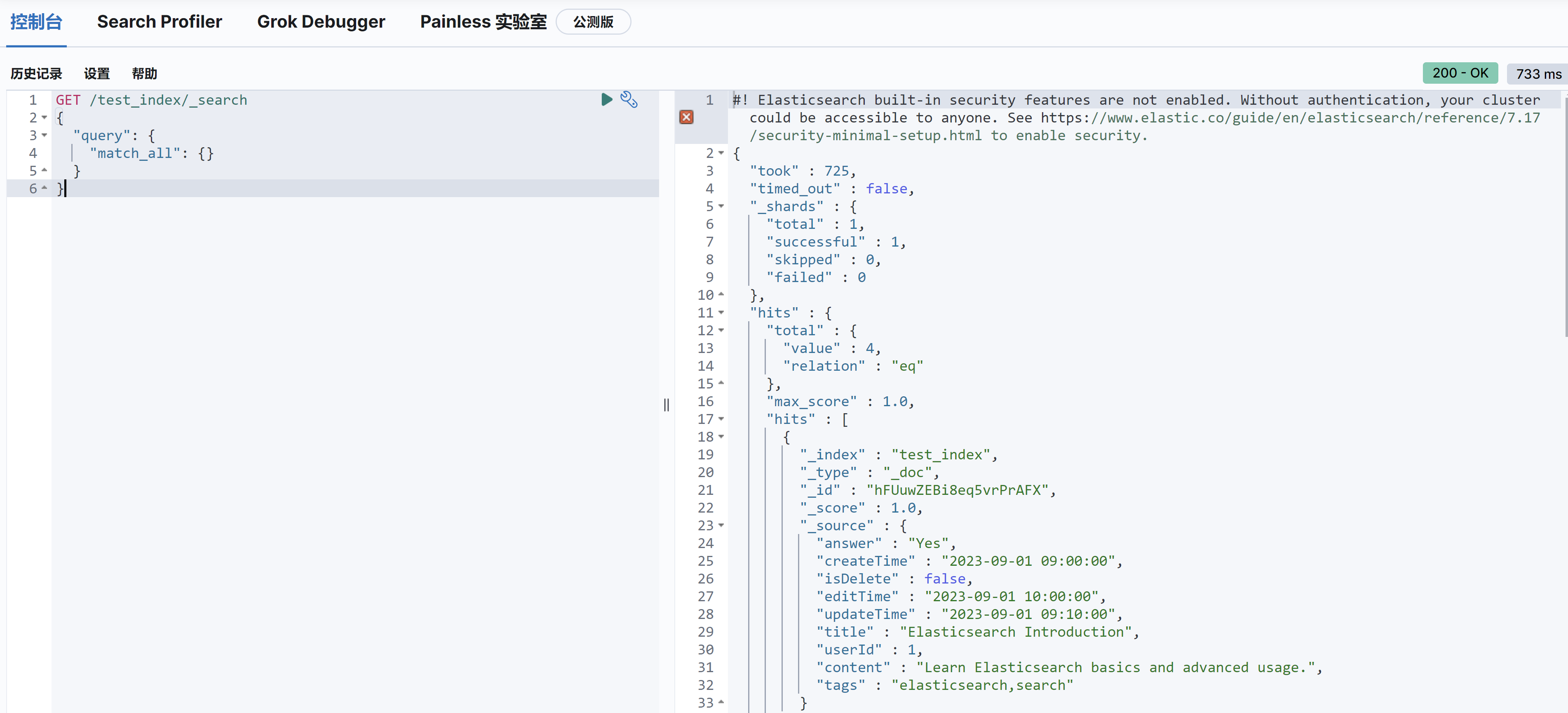

4)编写一个单元测试文件,验证对于 Elasticsearch 的增删改查基本操作

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 @SpringBootTest public class ElasticsearchRestTemplateTest { @Autowired private ElasticsearchRestTemplate elasticsearchRestTemplate; private final String INDEX_NAME = "test_index" ; @Test public void indexDocument () { Map<String, Object> doc = new HashMap <>(); doc.put("title" , "Elasticsearch Introduction" ); doc.put("content" , "Learn Elasticsearch basics and advanced usage." ); doc.put("tags" , "elasticsearch,search" ); doc.put("answer" , "Yes" ); doc.put("userId" , 1L ); doc.put("editTime" , "2023-09-01 10:00:00" ); doc.put("createTime" , "2023-09-01 09:00:00" ); doc.put("updateTime" , "2023-09-01 09:10:00" ); doc.put("isDelete" , false ); IndexQuery indexQuery = new IndexQueryBuilder ().withId("1" ).withObject(doc).build(); String documentId = elasticsearchRestTemplate.index(indexQuery, IndexCoordinates.of(INDEX_NAME)); assertThat(documentId).isNotNull(); } @Test public void getDocument () { String documentId = "1" ; Map<String, Object> document = elasticsearchRestTemplate.get(documentId, Map.class, IndexCoordinates.of(INDEX_NAME)); assertThat(document).isNotNull(); assertThat(document.get("title" )).isEqualTo("Elasticsearch Introduction" ); } @Test public void updateDocument () { String documentId = "1" ; Map<String, Object> updates = new HashMap <>(); updates.put("title" , "Updated Elasticsearch Title" ); updates.put("updateTime" , "2023-09-01 10:30:00" ); UpdateQuery updateQuery = UpdateQuery.builder(documentId) .withDocument(Document.from(updates)) .build(); elasticsearchRestTemplate.update(updateQuery, IndexCoordinates.of(INDEX_NAME)); Map<String, Object> updatedDocument = elasticsearchRestTemplate.get(documentId, Map.class, IndexCoordinates.of(INDEX_NAME)); assertThat(updatedDocument.get("title" )).isEqualTo("Updated Elasticsearch Title" ); } @Test public void deleteDocument () { String documentId = "1" ; String result = elasticsearchRestTemplate.delete(documentId, IndexCoordinates.of(INDEX_NAME)); assertThat(result).isNotNull(); } @Test public void deleteIndex () { IndexOperations indexOps = elasticsearchRestTemplate.indexOps(IndexCoordinates.of(INDEX_NAME)); boolean deleted = indexOps.delete(); assertThat(deleted).isTrue(); } }

可以用 kibana 开发者工具查看数据情况:

1 2 3 4 5 6 GET /test_index/_search { "query": { "match_all": {} } }

查出的数据如下所示:

几个注意事项:

当你向一个不存在的索引中插入数据时,Elasticsearch 会根据文档内容自动推断字段类型,并为这些字段创建映射。这就是 ES 的 动态映射 (Dynamic Mapping)功能。然而,这种自动生成的映射有一些局限性,可能导致字段类型不够规范。

ES 中,_开头的字段表示系统默认字段,比如 _id,如果系统不指定,会自动生成。但是不会在 _source 字段中补充 id 的值,所以建议大家手动指定,让数据更完整。

ES 插入和更新数据没有 MySQL 那么严格,尤其是在动态 Mapping 模式下,只要指定了相同的文档 id,ES 允许动态添加字段和更新文档。

ES 中下划线开头的代表是默认字段,凡是默认字段都不用明确指定。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 { "took" : 8, "timed_out" : false, "_shards" : { "total" : 1, "successful" : 1, "skipped" : 0, "failed" : 0 }, "hits" : { "total" : { "value" : 1, "relation" : "eq" }, "max_score" : 1.0, "hits" : [ { "_index" : "test_index", "_type" : "_doc", "_id" : "1", "_score" : 1.0, "_source" : { "answer" : "Yes", "createTime" : "2023-09-01 09:00:00", "isDelete" : false, "editTime" : "2023-09-01 10:00:00", "updateTime" : "2023-09-01 10:30:00", "title" : "Updated Elasticsearch Title", "userId" : 1, "content" : "Learn Elasticsearch basics and advanced usage.", "tags" : "elasticsearch,search" } } ] } }

source 代表是真正的数据,而 _id 代表文档的 id,我们最好在插入数据时指定真正数据的 id

总结

通过这个单元测试,我们也能基本了解 Spring Data Elasticsearch 操作 ES 的方法:

构造一个 Query 对象,比如插入数据使用 IndexQuery,更新数据使用 UpdateQuery

调用 elasticsearchRestTemplate 的增删改查方法,传入 Query 对象和要操作的索引作为参数

对返回值进行处理

实例代码如下:

1 2 3 4 5 6 7 8 9 10 11 Map<String, Object> updates = new HashMap <>(); updates.put("title" , "Updated Elasticsearch Title" ); updates.put("updateTime" , "2023-09-01 10:30:00" ); UpdateQuery updateQuery = UpdateQuery.builder(documentId) .withDocument(Document.from(updates)) .build(); elasticsearchRestTemplate.update(updateQuery, IndexCoordinates.of(INDEX_NAME)); Map<String, Object> updatedDocument = elasticsearchRestTemplate.get(documentId, Map.class, IndexCoordinates.of(INDEX_NAME));

但是有个问题就是,上述代码都是用 Map 传递数据,不像在 MyBatis 中利用实例类传递参数。当然 Spring Data ES 也支持这种方法来传递参数

5、编写 ES Dao 层 1)在 model.dto.question 包中定义和 ES 对应的实体类:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 @Document(indexName = "question") @Data public class QuestionEsDTO implements Serializable { private static final String DATE_TIME_PATTERN = "yyyy-MM-dd HH:mm:ss" ; @Id private Long id; private String title; private String content; private String answer; private List<String> tags; private Long userId; @Field(type = FieldType.Date, format = {}, pattern = DATE_TIME_PATTERN) private Date createTime; @Field(type = FieldType.Date, format = {}, pattern = DATE_TIME_PATTERN) private Date updateTime; private Integer isDelete; private static final long serialVersionUID = 1L ; public static QuestionEsDTO objToDto (Question question) { if (question == null ) { return null ; } QuestionEsDTO questionEsDTO = new QuestionEsDTO (); BeanUtils.copyProperties(question, questionEsDTO); String tagsStr = question.getTags(); if (StringUtils.isNotBlank(tagsStr)) { questionEsDTO.setTags(JSONUtil.toList(tagsStr, String.class)); } return questionEsDTO; } public static Question dtoToObj (QuestionEsDTO questionEsDTO) { if (questionEsDTO == null ) { return null ; } Question question = new Question (); BeanUtils.copyProperties(questionEsDTO, question); List<String> tagList = questionEsDTO.getTags(); if (CollUtil.isNotEmpty(tagList)) { question.setTags(JSONUtil.toJsonStr(tagList)); } return question; } }

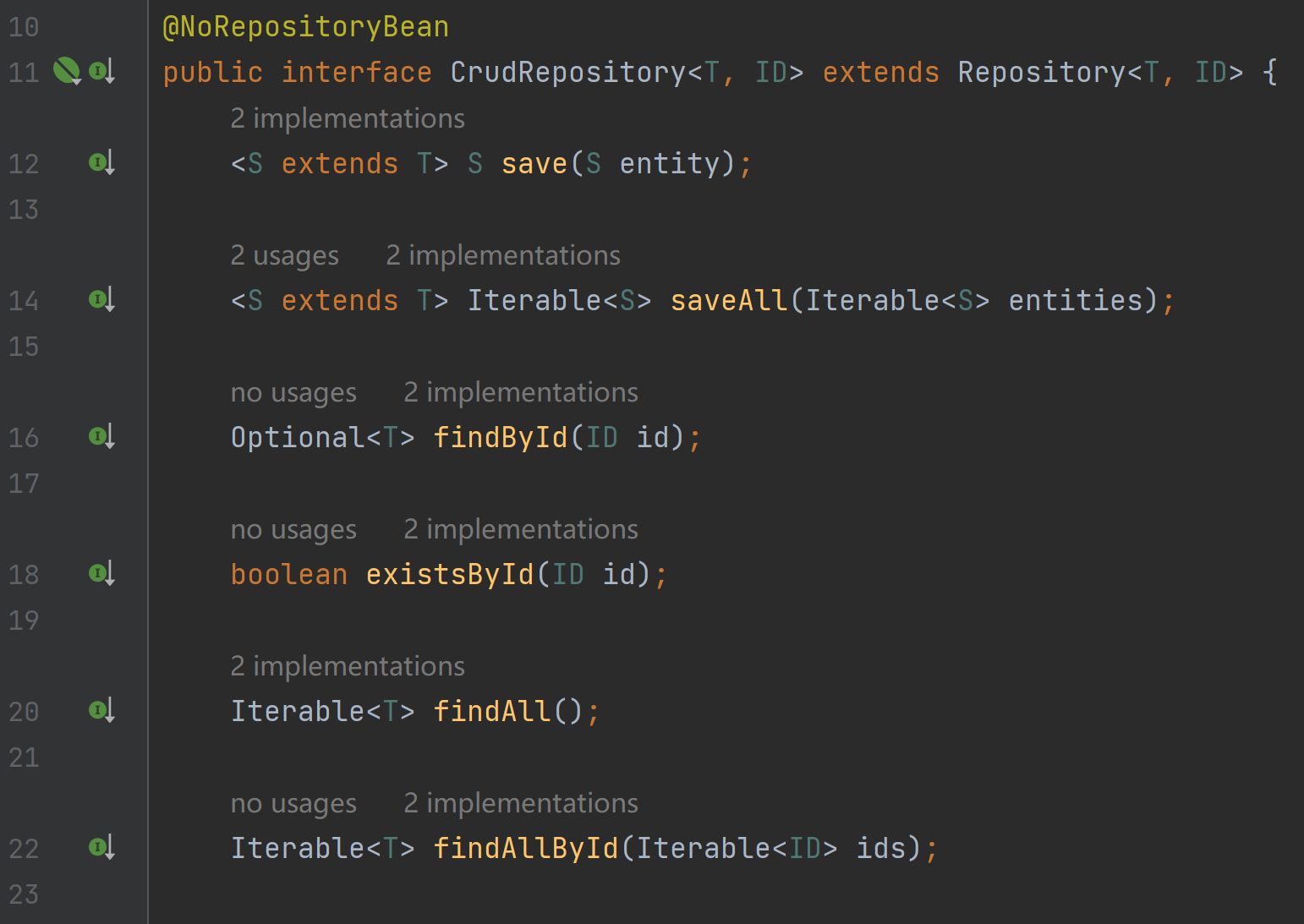

2)定义 Dao 层

可以在 esdao 包中统一存放对 Elasticsearch 的操作,只需要继承 ElasticsearchRepository 类即可。

1 2 3 4 5 6 7 public interface QuestionEsDao extends ElasticsearchRepository <QuestionEsDTO, Long> { }

仔细了解后可以知道 ElasticsearchRepository 类为我们提供了大量现成的 CRUD 操作:

而且还支持根据方法名自动映射为查询操作,比如在 QuestionEsDao 中定义下列方法,就会自动根据 userId 查询数据。

1 2 3 4 5 6 List<QuestionEsDTO> findByUserId (Long userId) ;

编写一个测试类来验证下:

1 2 3 4 5 6 7 8 9 10 11 @SpringBootTest class QuestionEsDaoTest { @Resource private QuestionEsDao questionEsDao; @Test void findByUserId () { questionEsDao.findByUserId(1L ); } }

两种操作 ES 的方法,根据业务需求进行选择:

第 1 种方式:Spring 默认给我们提供的操作 es 的客户端对象 ElasticsearchRestTemplate,也提供了增删改查,它的增删改查更灵活,适用于更复杂的操作 ,返回结果更完整,但需要自己解析。

第 2 种方式:ElasticsearchRepository<Entity, IdType>,默认提供了更简单易用的增删改查,返回结果也更直接。适用于可预期的、相对简单的操作 。

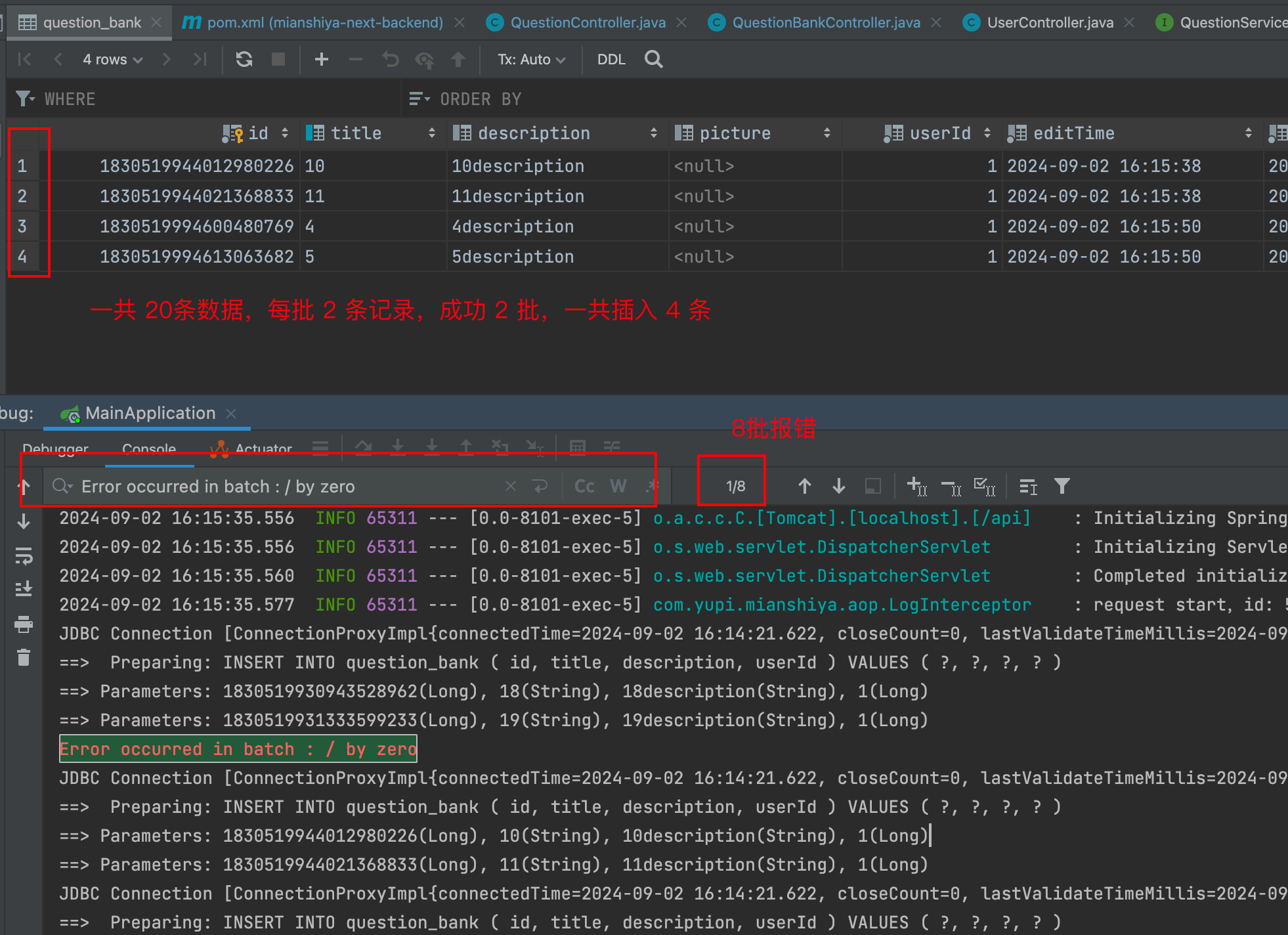

6、如何向 ES 写入全量数据 可以通过编写单次执行的任务,将 MySQL 中题目表的数据,全量写入到 Elasticsearch。

可以通过实现 CommandLineRunner 接口定义单次任务,也可以编写一个仅管理员可用的接口,根据需要选择就好。

在 job/once 目录下编写任务:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 @Component @Slf4j public class FullSyncQuestionToEs implements CommandLineRunner { @Resource private QuestionService questionService; @Resource private QuestionEsDao questionEsDao; @Override public void run (String... args) { List<Question> questionList = questionService.list(); if (CollUtil.isEmpty(questionList)) { return ; } List<QuestionEsDTO> questionEsDTOList = questionList.stream() .map(QuestionEsDTO::objToDto) .collect(Collectors.toList()); final int pageSize = 500 ; int total = questionEsDTOList.size(); log.info("FullSyncQuestionToEs start, total {}" , total); for (int i = 0 ; i < total; i += pageSize) { int end = Math.min(i + pageSize, total); log.info("sync from {} to {}" , i, end); questionEsDao.saveAll(questionEsDTOList.subList(i, end)); } log.info("FullSyncQuestionToEs end, total {}" , total); } }

编写一个测试方法,将题目全量同步到 Es 中

1 2 3 4 @Test public void fullSyncQuestionToEs () { fullSyncQuestionToEs.run(); }

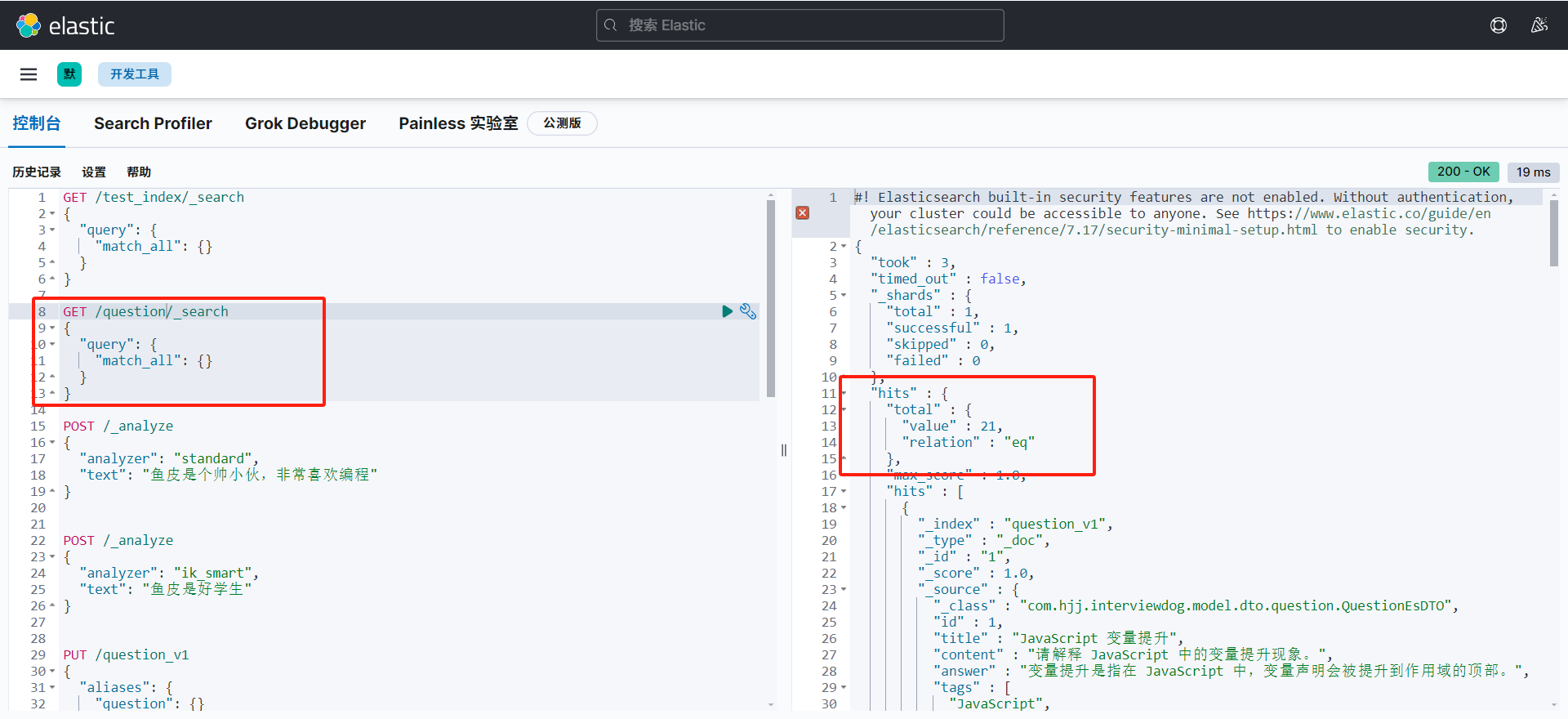

随后在 kibana 面板中查看所有数据,发现写入成功

1 2 3 4 5 6 GET /question/_search { "query" : { "match_all" : { } } }

7、开发 ES 搜索 1)QuestionService 新增查询接口

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 @Override public Page<Question> searchFromEs (QuestionQueryRequest questionQueryRequest) { Long id = questionQueryRequest.getId(); Long notId = questionQueryRequest.getNotId(); String searchText = questionQueryRequest.getSearchText(); List<String> tags = questionQueryRequest.getTags(); Long questionBankId = questionQueryRequest.getQuestionBankId(); Long userId = questionQueryRequest.getUserId(); int current = questionQueryRequest.getCurrent() - 1 ; int pageSize = questionQueryRequest.getPageSize(); String sortField = questionQueryRequest.getSortField(); String sortOrder = questionQueryRequest.getSortOrder(); BoolQueryBuilder boolQueryBuilder = QueryBuilders.boolQuery(); boolQueryBuilder.filter(QueryBuilders.termQuery("isDelete" , 0 )); if (id != null ) { boolQueryBuilder.filter(QueryBuilders.termQuery("id" , id)); } if (notId != null ) { boolQueryBuilder.mustNot(QueryBuilders.termQuery("id" , notId)); } if (userId != null ) { boolQueryBuilder.filter(QueryBuilders.termQuery("userId" , userId)); } if (questionBankId != null ) { boolQueryBuilder.filter(QueryBuilders.termQuery("questionBankId" , questionBankId)); } if (CollUtil.isNotEmpty(tags)) { for (String tag : tags) { boolQueryBuilder.filter(QueryBuilders.termQuery("tags" , tag)); } } if (StringUtils.isNotBlank(searchText)) { boolQueryBuilder.should(QueryBuilders.matchQuery("title" , searchText)); boolQueryBuilder.should(QueryBuilders.matchQuery("content" , searchText)); boolQueryBuilder.should(QueryBuilders.matchQuery("answer" , searchText)); boolQueryBuilder.minimumShouldMatch(1 ); } SortBuilder<?> sortBuilder = SortBuilders.scoreSort(); if (StringUtils.isNotBlank(sortField)) { sortBuilder = SortBuilders.fieldSort(sortField); sortBuilder.order(CommonConstant.SORT_ORDER_ASC.equals(sortOrder) ? SortOrder.ASC : SortOrder.DESC); } PageRequest pageRequest = PageRequest.of(current, pageSize); NativeSearchQuery searchQuery = new NativeSearchQueryBuilder () .withQuery(boolQueryBuilder) .withPageable(pageRequest) .withSorts(sortBuilder) .build(); SearchHits<QuestionEsDTO> searchHits = elasticsearchRestTemplate.search(searchQuery, QuestionEsDTO.class); Page<Question> page = new Page <>(); page.setTotal(searchHits.getTotalHits()); List<Question> resourceList = new ArrayList <>(); if (searchHits.hasSearchHits()) { List<SearchHit<QuestionEsDTO>> searchHitList = searchHits.getSearchHits(); for (SearchHit<QuestionEsDTO> questionEsDTOSearchHit : searchHitList) { resourceList.add(QuestionEsDTO.dtoToObj(questionEsDTOSearchHit.getContent())); } } page.setRecords(resourceList); return page; }

虽然看上去复杂,但不涉及什么逻辑,根据查询需求选择合适的搜索方法,不断构造搜索条件即可。

3)在 QuestionController 编写新的搜索接口

1 2 3 4 5 6 7 8 9 @PostMapping("/search/page/vo") public BaseResponse<Page<QuestionVO>> searchQuestionVOByPage (@RequestBody QuestionQueryRequest questionQueryRequest, HttpServletRequest request) { long size = questionQueryRequest.getPageSize(); ThrowUtils.throwIf(size > 200 , ErrorCode.PARAMS_ERROR); Page<Question> questionPage = questionService.searchFromEs(questionQueryRequest); return ResultUtils.success(questionService.getQuestionVOPage(questionPage, request)); }

8、数据同步 我们需要编写一个定时方法,每 5 分钟同步 MySQL 数据至 ES

因为 MyBatis-Plus 查询的数据是逻辑未被删除的数据,因此我们要查出所有数据并同步到 ES,因此需要再 QuestionMapper 重写一个查询所有题目的方法

1)编写查询所有题目的方法

1 2 3 4 5 6 7 public interface QuestionMapper extends BaseMapper <Question> { @Select("select * from question where updateTime >= #{minUpdateTime}") List<Question> listAllQuestion (Date minUpdateTime) ; }

2)在 /job/circle 包下编写定时方法,保证每 5 分钟都会将题目数据同步到 ES

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 @Component @Slf4j public class IncSyncQuestionToEs { @Resource private QuestionMapper questionMapper; @Resource private QuestionEsDao questionEsDao; @Scheduled(fixedRate = 60 * 1000) public void run () { long FIVE_MINUTES = 5 * 60 * 1000L ; Date fiveMinutesAgoDate = new Date (new Date ().getTime() - FIVE_MINUTES); List<Question> questionList = questionMapper.listQuestionWithDelete(fiveMinutesAgoDate); if (CollUtil.isEmpty(questionList)) { log.info("no inc question" ); return ; } List<QuestionEsDTO> questionEsDTOList = questionList.stream() .map(QuestionEsDTO::objToDto) .collect(Collectors.toList()); final int pageSize = 500 ; int total = questionEsDTOList.size(); log.info("IncSyncQuestionToEs start, total {}" , total); for (int i = 0 ; i < total; i += pageSize) { int end = Math.min(i + pageSize, total); log.info("sync from {} to {}" , i, end); questionEsDao.saveAll(questionEsDTOList.subList(i, end)); } log.info("IncSyncQuestionToEs end, total {}" , total); } }

前端开发 运行 openAPI 重新生成前端请求代码

更改题目列表和题目表格的查询题目接口

1 2 3 4 5 6 7 8 9 10 11 12 const res = await searchQuestionVoByPageUsingPost ({ searchText, pageSize : pageSize, sortField : 'createTime' , sortOrder : 'desc' , }); const {data, code} = await searchQuestionVoByPageUsingPost ({ ...params, sortField, sortOrder, ...filter, } as API .QuestionQueryRequest );

拓展 1、根据业务自定义 ES 词典,提高分词准确度 思路:可以参考 IK 分词插件的官方文档:https://github.com/infinilabs/analysis-ik/tree/v7.17.18?tab=readme-ov-file#dictionary-configuration

2、使用 ES 查询时,关联获取题目的动态数据 思路:先查 ES,再从 DB 查询其他的数据

3、ES 接口支持降级 需求:ES 挂了、或者未搭建 ES 环境时,照样能把项目跑起来。

思路:ES 如果查询报错,改为调用数据库查询;还可以根据 ES 客户端是否正确初始化来判断是否应该使用 ES。

4、防止重复执行定时任务 可以自定义实现一个分布式锁注解,以下仅供参考:

1)创建一个自定义注解 @DistributedLock

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 @Target(ElementType.METHOD) @Retention(RetentionPolicy.RUNTIME) public @interface DistributedLock { String key () ; long leaseTime () default 30000 ; long waitTime () default 10000 ; TimeUnit timeUnit () default java.util.concurrent.TimeUnit.MILLISECONDS; }

2)创建一个切面类,用来处理 @DistributedLock 注解